Alexei Grinbaum, directeur de recherche au CEA estime que le modèle R1 de Deepseek est en rupture sur deux points : son côté open source et la technique d'apprentissage par renforcement. (Crédit Photo : IT News Info)

Propulsée sur le devant de la scène, la start-up chinoise Deepseek et son modèle de raisonnement R1 intriguent. Pourquoi un tel engouement ? Quelles sont les différences par rapport à des modèles similaires ? Quelles infrastructures utilise-t-il ? Décryptage avec un expert de l'IA.

Encore inconnue il y a quelques semaines, la société chinoise Deepseek à l'origine du modèle de raisonnement R1 est devenue en quelques jours un phénomène en inquiétant les grands acteurs de l'IA. Son application de GenAI - également appelé Deepseek et reposant sur son LLM R1 - a pris la tête des programmes les plus téléchargés sur l'App Store d'Apple. Plus performant, entraîné à moindre coût, open source, le LLM affiche ses avantages par rapport à la concurrence. Pour en savoir plus, Alexei Grinbaum, directeur de recherche et président du comité opérationnel d'éthique du numérique du CEA nous donne son éclairage.

Une méthode d'apprentissage par renforcement plus ciblée

Pour lui, le LLM R1 de Deepsek « n'est pas révolutionnaire, mais il marque une étape sur deux points. Tout d'abord, c'est la première fois qu'un modèle de raisonnement est mis en open source et l'autre point réside dans la technique utilisée pour l'apprentissage par renforcement », observe-t-il. Sur la technique, il sépare « le modèle de fondation (Deepseek v3) et celui de raisonnement (R1). Sur le premier, la méthode d'apprentissage par renforcement « s'est faite sans annotations humaines ». Par contre, sur le second, l'apprentissage par renforcement a été supervisé par l'humain ». Une différence avec o1 d'OpenAI où « la supervision humaine est présente sur les deux modèles ». A noter aussi un phénomène inexpliqué baptisé le « moment aha », par les experts de Deepseek sur le modèle de fondation. « Il apprend à consacrer plus de temps de réflexion à un problème en réévaluant son approche initiale », soulignent-ils dans leur document de travail.

En termes de benchmark, « le modèle de fondation derrière R1 n'est pas très bon par rapport à o1 d'OpenAI, par contre son modèle de raisonnement est aussi performant », indique le chercheur. Pour lui la clé est à chercher dans « le dataset qui a servi au modèle de fondation, il est très qualifié et il y a eu un grand travail en amont sur ce point. » Pour autant, impossible de savoir exactement ce que contient ce jeu de données « cette partie n'est pas open source », regrette-t-il. Alexei Grinbaum salue également « la qualité de l'algorithme utilisée. »

Une distillation plus efficace

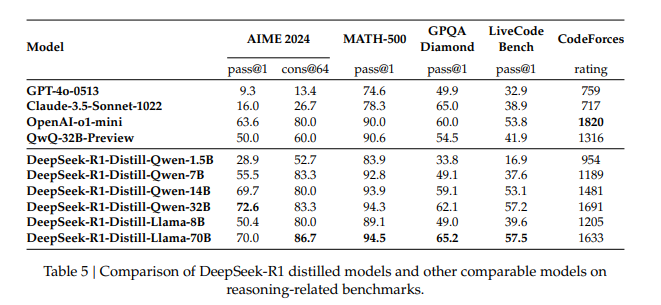

Autre enseignement des travaux de Deepseek, « la distillation du modèle R1 en de plus petits modèles les rend plus efficace », explique Alexei Grinbaum. Pour lui « c'est une énorme découverte. Nous nous apercevons aujourd'hui que l'on peut reproduire le modèle doté de 671 milliards de paramètres et le distiller dans des modèles de 7 à 3 milliards de paramètres plus performants que les SLM créent à partir de zéro. »

Deepseek a présenté ses deux premiers SLM distillés : l'un basé sur le LM Qwen développé par Alibaba Cloud et l'autre sur Llama de Meta. Les chercheurs précisent qu'ils n'ont pas appliqué « d'affinage supervisé » ou « d'apprentissage par renforcement. » Les résultats poussés par les experts montrent des gains d'efficacité sur l'ensemble des tests face à la concurrence. « Cela signifie que le modèle de raisonnement est réplicable sur des plus petits modèles et que cela fonctionne mieux pour certaines tâches », dit Alexei Grinbaum. Il constate une effervescence de la communauté open source sur Hugging Face depuis la sortie de R1, « des groupes travaillent justement sur cette réplication sur leur propre modèle. »

Les modèles distillés de DeepSeek affichent de meilleures performances par rapport à la concurrence. (Crédit Photo : Deepseek)

Une infrastructure IA qui questionne

Outre les aspects algorithmiques, l'intérêt pour Deepseek porte sur l'utilisation d'une infrastructure IA "minimaliste" et un développement à moindre coût. D'après la start-up, elle se sert d'un cluster de 2 048 GPU H800 de Nvidia. Ces puces ont été développées à la fin 2023 par le fournisseur pour répondre à la limitation américaine des exportations des puces avancées vers la Chine. Une infrastructure qui interroge plusieurs spécialistes. Jimmy Goodrich, conseiller auprès de Rand Corp (société de conseil américaine auprès du ministère de la Défense) questionné par Reuters, indique « il existe au moins une douzaine de supercalculateurs majeurs en Chine équipés d'un nombre important de puces Nvidia dont l'achat était légal au moment où DeepSeek les a utilisés pour apprendre à devenir plus efficace. » Alexander Wang, CEO de Scale AI (spécialisé dans le développement d'applications à base d'IA) est plus suspicieux, « les laboratoires chinois ont plus de H100 qu'on ne le pense » souligne-t-il dans une interview à CNBC. Il ajoute « je crois savoir que DeepSeek possède environ 50 000 H100, dont ils ne peuvent évidemment pas parler, car cela va à l'encontre des contrôles à l'exportation mis en place par les États-Unis. »

D'autres interrogations portent sur le coût du modèle R1, estimé selon Deepseek à 5,7 M$. Or la société n'a pas donné de détails sur la ventilation des coûts, laissant plusieurs observateurs penser que le montant total ne comprend pas certains éléments comme le nombre de GPU mobilisés pour la formation du modèle. Chez les concurrents OpenAI et Anthropic les montants dépensés pour l'entrainement des modèles atteint des sommes astronomiques, respectivement de 7 Md$ et de (2,7 Md$. Une chose est sûre cependant : « avec le travail en amont sur le dataset, le besoin en calcul est moindre », admet Alexei Grinbaum. Une efficience qui pourrait ainsi permettre à l'éditeur chinois de ne pas avoir à investir autant que ses concurrents dans l'entraînement et le développement de LLM. Notre confrère d'IDG indique que Deepseek a amélioré l'efficacité de la bande passante de la mémoire grâce à deux innovations clés: l'utilisation d'un algorithme optimisé (compression du cache clé-valeur) et le passage de FP32 (32 bits) à FP8 (8 bits) pour l'entraînement à la précision du modèle. La réduction de la mémoire requise permet d'entraîner des modèles plus volumineux et de réduire le temps d'entraînement.

Un rééquilibrage de la géopolitique de l'IA

L'aspect géopolitique de l'ascension de Deepseek n'est pas non plus à négliger. La prédominance des américains a été écornée dans ce domaine. Marc Andressen, un des plus gros investisseurs dans l'IT aux Etats-Unis a qualifié cette arrivée de « moment spoutnick », en référence la découverte du satellite russe, qui a rebattu les cartes de la conquête spatiale majoritairement dominée par les Etats-Unis. « Avec Deepseeck, la Chine rattrape son retard sur les américains avec une modèle plus optimisé et plus efficace », affirme Alexei Grinbaum.

Il s'attend à ce que les grands acteurs IA américains ripostent « avec la présentation prochaine du modèle o3 d'OpenAI. » De son côté, la start-up chinoise va certainement améliorer son modèle de raisonnement R1 et en renforcer la sécurité. Ce lundi, la société a communiqué sur une cyberattaque « à grande échelle » qui l'a forcée à restreindre le nombre d'inscriptions.

Suivez-nous