CEO et cofondateur de WekaIO, Liran Zvibel a un pied en Israël et l'autre aux Etats-Unis. (Crédit S.L.)

Les traitements IA ne sont pas qu'un buzz word, c'est une réalité qui demande des ressources performantes pour assurer des réponses rapides. WekaIO a développé son système de fichiers distribué et parallèle pour répondre à ces besoins.

En direct de Sunnyvale. Fondée en janvier 2014 à Tel Aviv, en Israël, WekaIO a développé un système de fichiers haute performance (parallèle et distribué) avec un faible temps de latence sur des systèmes flash x86 pour les besoins HPC, IA et ML. Baptisé Matrix, ce système de fichiers peut fonctionner en mode objets sur des serveurs dédiés, dans un cluster hyper-converti ou dans le cloud (AWS et autres fournisseurs compatibles S3). Liran Zvibel, CEO et cofondateur de la société, nous a accueilli dans ses bureaux californiens pour mettre en avant ses dernières innovations. « La latence sur des baies de stockage flash est jusqu'à 10 fois inférieures à celle des concurrents », nous a indiqué le CEO en avant-propos.

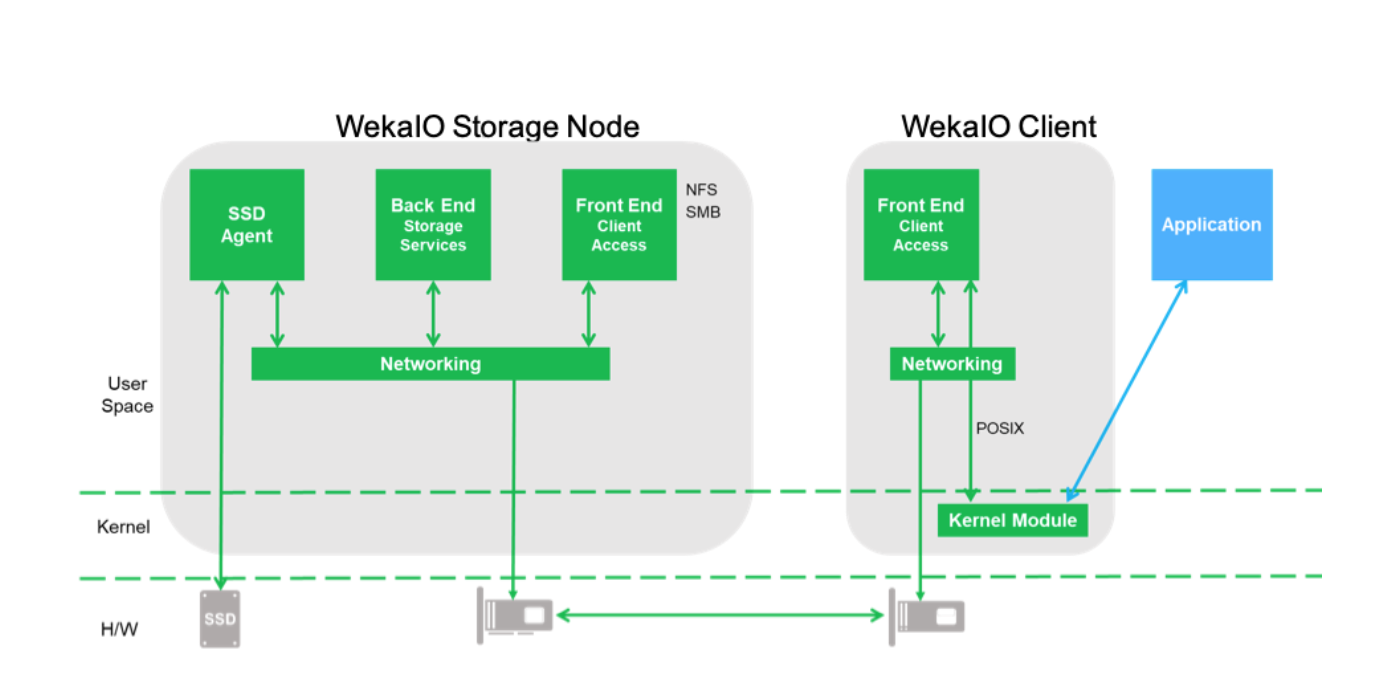

Le système a été conçu pour exploiter les ressources des baies flash. À l'origine, la société ne s'appuyait pas sur le NVMe Over Fabrics mais exploiter des SSD classiques dotés d'un interface SATA ou SAS sur réseau Ethernet sans cartes ou commutateurs spécifiques. Elle est toutefois passée au NVMe Over Fabrics depuis la v3 de Matrix. Travaillant avec son propre gestionnaire mémoire, Matrix parle directement aux SSD du serveur sans passer par le noyau Linux pour fournir une latence très faible. Lorsqu'une application a besoin de ressources fichiers, elle passe simplement des appels système à un pilote Linux, WekaIO VFS, en respectant les exigences POSIX pour assurer un traitement distribué, parallèle et cohérent. Matrix assure des fonctionnalités complémentaires comme les clones snapshots (en local ou sur AWS S3), la gestion du tiering et exploite son propre algorithme d'erasure coding pour réduire les pertes de données et accélérer la reconstruction d'un noeud en cas de défaillance.

L'architecture Matrix de WekaIO repose sur plusieurs noeuds conservant chacun les données et les métadata. (Crédit WekaIO).

Comme Pure Storage ou DDN, WekaIO propose également une solution prêt à l'emploi dédiée à l'IA avec le concours de Nvidia et son serveur DGX-1 dopé avec des accélérateurs GPU Tesla V100. L'idée est de fournir une plateforme prête à l'emploi pour mettre en oeuvre des traitements deep learning haute performance. Nvidia, qui vient de racheter Mellanox, développe sans détours tous les partenariats permettant de booster ses revenus issus de l'IA. Les GPU demandent jusqu'à 10 fois plus d'I/O que ce que les systèmes NFS fournissent aujourd'hui, selon Barbara Murphy vice-présidente en charge du marketing chez WekaIO. Les NAS ne peuvent plus suivre les besoins des systèmes IA ce qui profitent à WekaIO, Pure Storage ou DDN.

Un dernier tour de table de 31,7 M$

WekaIO travaille avec un grand nombre de partenaires dont HPE ou SuperMicro, mais également des revendeurs channel. Récemment, Nvidia est venu rejoindre les investisseurs de la start-up au coté de HPE, Qualcomm, Seagate et Western Digital dans un tour de table de série C d'un montant de 31,7 millions de dollars. WekaIO a jusqu'à présent levé 66,7 millions de dollars pour assurer son développement.

Suivez-nous