Dans son service SageMaker, AWS va proposer un choix d'algorithmes d'apprentissage machine déjà réalisés, a expliqué son CEO Andy Jassy sur Re:invent à Las Vegas. (crédit : D.R.)

A Las Vegas, la conférence Re:invent d'Amazon Web Services a été riche en annonces. Parmi les nouveaux services, SageMaker va simplifier la mise au point de modèles d'apprentissage machine. On y trouve Jupyter pour la préparation des données et tout l'environnement nécessaire pour créer, tester, déployer et mettre à l'échelle les modèles réalisés.

Avec SageMaker, AWS cherche à faciliter l'adoption des algorithmes d'intelligence artificielle auprès de ses utilisateurs. Managé de bout en bout, ce service permet de créer, entraîner et déployer des algorithmes d'apprentissage machine pour les applications d'entreprise en réduisant les charges manuelles associées à ces processus, le provisionnement d'infrastructures, mais aussi la gestion et l'ajustement des modèles d'entraînement. SageMaker permet aux data scientists, développeurs et experts du machine learning de bâtir rapidement des modèles et de les faire tourner à l'échelle souhaité, ainsi que l'explique dans un billet Randall Hunt, évangéliste technique senior d'AWS. L'ajout de fonctionnalités d'apprentissage machine aux applications s'en trouvera considérablement accéléré, souligne-t-il.

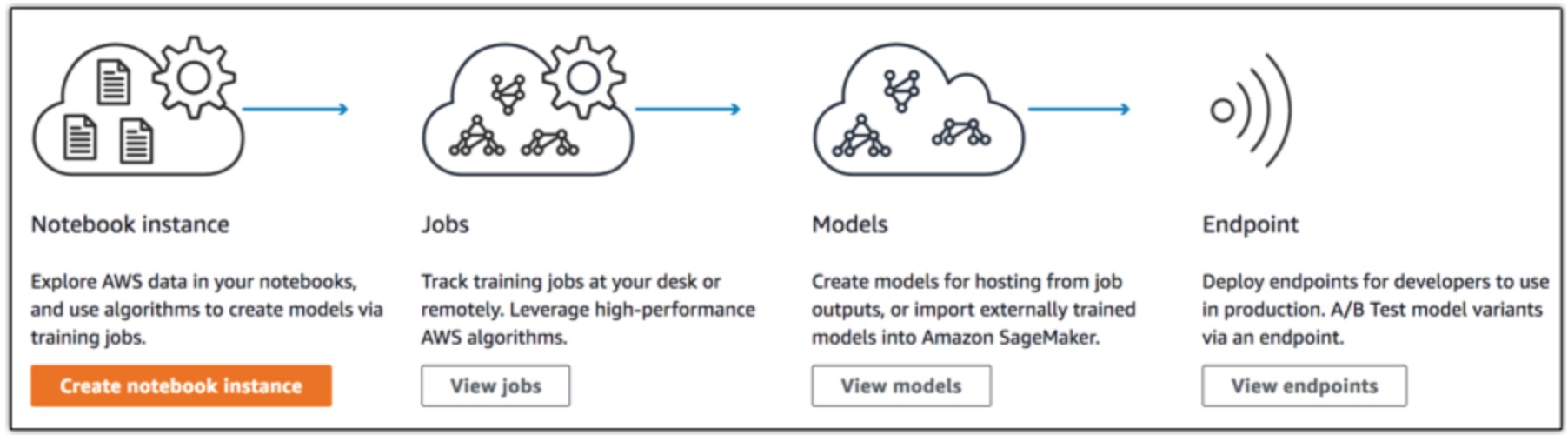

Derrière SageMaker se trouvent trois composants principaux. Premièrement, AWS fournit l'environnement de développement intégré Jupyter pour explorer, nettoyer et pré-traiter les données. Deuxièmement, un service permettra de construire des modèles distribués, de les entraîner et de les valider. Les entreprises pourront choisir parmi les algorithmes déjà réalisés et proposés par AWS ou bien importer un framework open source comme TensorFlow (développé par Google). Elles pourront aussi écrire et déployer leurs propres algorithmes avec les containers Dockers, directement dans SageMaker.

On peut créer ses modèles de ML dans SageMaker ou bien importer dans le service des modèles déjà créés.![]()

Enfin, troisièmement, on trouve dans SageMaker un service d'hébergement avec des terminaux https pour invoquer les modèles afin d'obtenir des inférences en temps réel, ainsi que l'explique AWS. Pour commencer à entraîner les modèles, on choisit un emplacement dans l'espace de stockage S3, ainsi que l'instance que l'on veut utiliser et, en un clic, SageMaker lance un cluster isolé et un réseau défini par logiciel avec des fonctions d'autoscaling et des pipelines de données. Des terminaux https sont donc utilisés pour l'hébergement des modèles. Leur puissance peut être augmentée pour supporter le trafic et faire de l'A/B testing simultanément sur plusieurs modèles. Les algorithmes peuvent être déployés directement en production à partir d'instances EC2, sur un clic. A la suite de quoi, ils seront déployés à travers plusieurs zones de disponibilité en bénéficiant de fonctions d'autoscaling.

HPO, une fonction pour optimiser le tuning de modèles

En général, le tuning de modèles est un exercice de test pour voir ce qui fonctionne. Mais SageMaker est fourni avec ce qu'AWS appelle des appels HPO, optimisation hyper paramètre. En cochant simplement une case, le service va lancer plusieurs copies du modèle d'entraînement et utiliser le machine learning pour repérer chaque changement en parallèle et ajuster les paramètres en conséquence.

Démocratiser l'apprentissage machine et l'IA, c'est donc l'un des messages-clés du keynote délivré d'Andy Jassy sur la conférence Re:Invent qui s'est tenue cette semaine à Las Vegas (du 27 novembre au 1er décembre). « Si vous voulez permettre à la plupart des entreprises d'utiliser le machine learning de façon expensive, nous devons résoudre le problème de l'accessibilité quotidienne aux développeurs et aux scientifiques », a déclaré le CEO. Dans cette perspective, SageMaker se présente sous une forme agnostive, supportant la plupart des frameworks les plus utilisés, depuis TensorFlow bien sûr, jusqu'à Caffe2 et à la propre bibliothèque Gluon d'AWS.

D'ores et déjà, TensorFlow est davantage utilisé sur AWS que n'importe où ailleurs, assure Andy Jassy, ce qui ne doit pas particulièrement réjouir l'équipe de la Google Cloud Platform. Quoi qu'il en soit, le principe général d'AWS est de fournir toutes les solutions les plus importantes « afin que vous ayez les outils dont vous avez besoin pour la tâche que vous voulez effectuer », a conclu le CEO.

Suivez-nous