La gamme HPC DGX s'étoffe avec le serveur DGX Station A100 et le DGX SuperPod en mode supercalculateur. (Crédit Nvidia)

De la location de matériel HPC aux outils pour accélérer l'IA, Nvidia a tenu un GTC 2021 en mode virtuel particulièrement dense. Le fournisseur de solutions d'accélération graphiques et HPC penche de plus en plus vers le datacenter.

Avec quelques dizaines de communiqués de presse et de billets de blog combinés, personne ne peut dire que la GPU Technology Conference (GTC) de Nvidia est une affaire modeste. Comme celle de l'année dernière, elle s'est déroulée en mode virtuelle pour cause de pandémie, de sorte que de nombreuses annonces proviennent de la cuisine du CEO Jen-Hsun Huang. Voici un récapitulatif des annonces les plus pertinentes pour les opérateurs de centres de données.

Deux déclinaisons de l'Ampère 100

Aujourd'hui, le GPU phare de Nvidia est l'Ampere A100, présenté l'année dernière. Il s'agit d'une puce puissante, idéale pour les supercalculateurs, le calcul haute performance (HPC) et les projets d'intelligence artificielle (IA) de grande envergure, mais elle est également surdimensionnée pour certains cas d'utilisation et certains budgets. C'est pourquoi, lors de la GTC 2021, le fournisseur a présenté deux déclinaisons de son produit phare A100 : l'A30, destiné aux serveurs d'intelligence artificielle et d'analyse ordinaire, et l'A10, conçu pour les charges de travail mixtes (calcul et rendu 3D). Ces deux GPU ont été rabotés par rapport à l'A100, plus gros, plus puissant et plus consommateur d'énergie.

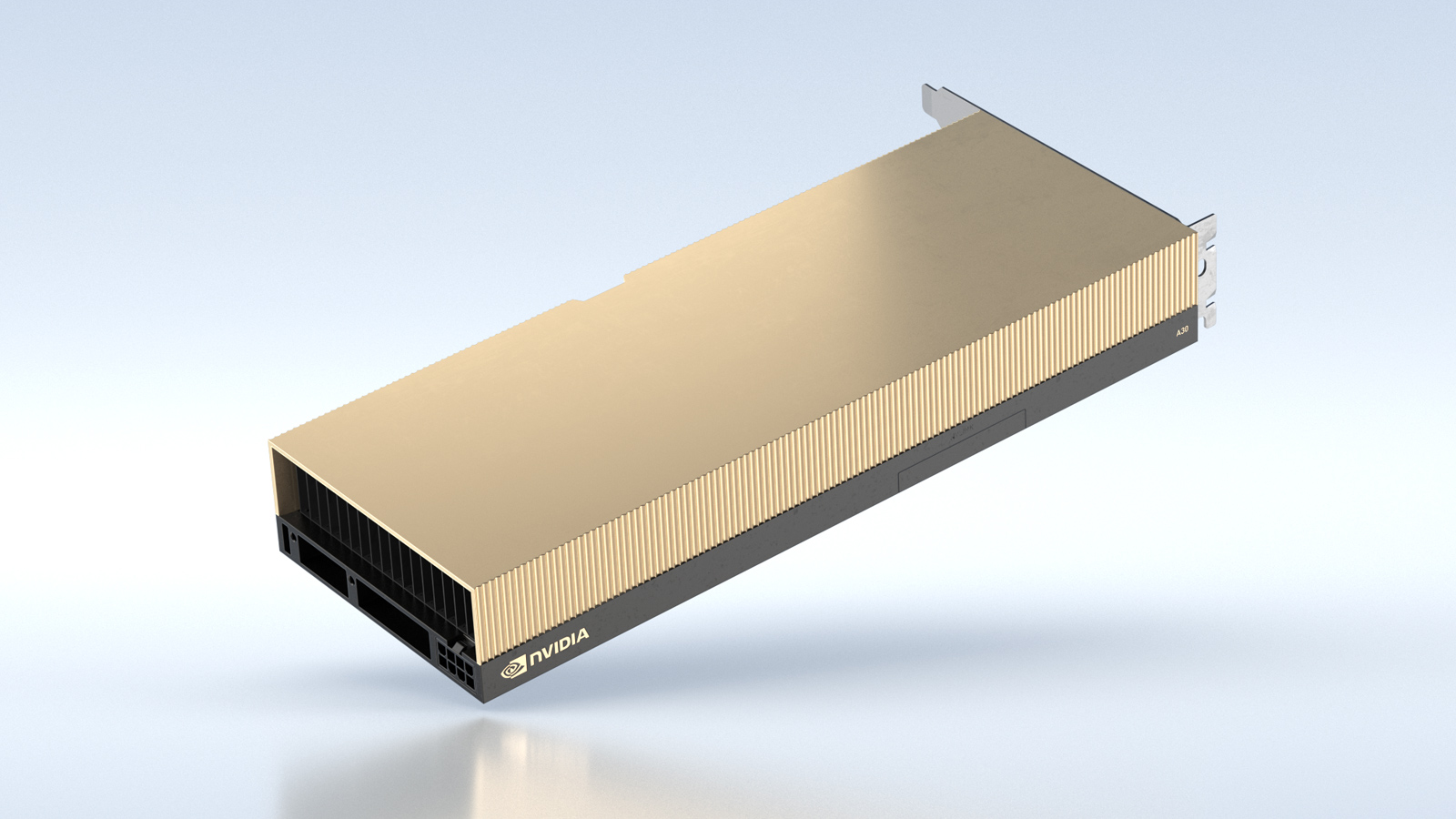

Déclinaison milieu de gamme de l'A100, le GPU A30 offre la moitié des performances du premier. (Crédit Nvidia)

L'A30, par exemple, prend en charge la même précision mathématique que l'A100 pour l'IA et les charges de travail HPC (Floating Point 64 jusqu'à INT4) et le partitionnement GPU multi-instance (MIG), mais il offre la moitié des performances de l'A100 avec moins de mémoire et moins de coeurs. L'A10 est également dérivé de l'A100, mais il est encore moins performant que l'A30. Par exemple, il ne prend pas en charge le FP64, seulement le FP32. Il est équipé de mémoire GDDR6 au lieu de la HBM2 plus rapide et plus chère de l'A100. Il est destiné à des charges de travail telles que le rendu 3D, l'inférence IA et l'encodage vidéo. Nvidia n'a pas fixé de date de sortie pour ces deux cartes.

DGX en mode souscription

Les principaux fournisseurs de matériel informatique (Cisco, Dell, HPE, NetApp ou encore Pure Storage) proposent une option location, il était logique que Nvidia le fasse aussi. Le dernier serveur HPC de la société, le DGX Station A100, peut désormais être loué pour une courte période, puis restitué lorsque vous avez terminé. Le programme est officiellement connu sous le nom de Nvidia Financial Solutions (NVFS). C'est une décision judicieuse. Les entreprises n'ont pas des besoins constants en supercalculateurs comme, par exemple, Météo France. Dans de nombreux cas, ils n'auront besoin de puissance de calcul que pendant une courte période, peut-être quelques fois par an. Un investissement de plusieurs millions d'euros n'a donc aucun sens pour un matériel qui risque de rester sous-exploité. La firme de San José a également annoncé le DGX SuperPod qui sera disponible avec les DPU Bluefield-2, permettant un supercalculateur "cloud-native". Un DGX SuperPod se compose d'un ensemble de serveurs DGX Station dans un facteur de forme 4U montable en rack. Il s'agit d'un superordinateur entièrement à nu, auxquels il faut greffer un environnement d'exploitation, et qui peut également être partagé.

Feuille de route des puces

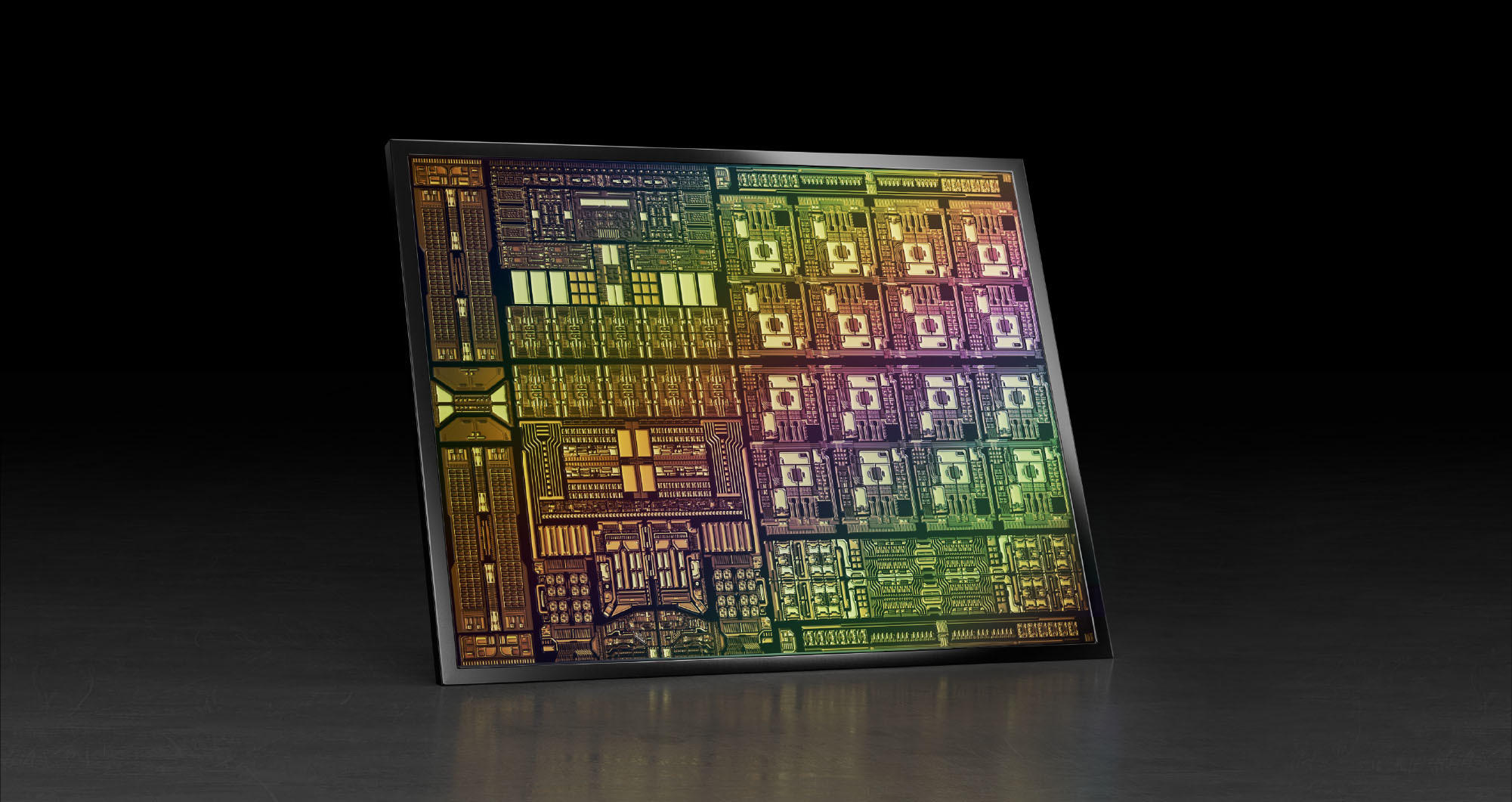

Nvidia est loin de rester inactif en matière de développement. Le CEO Huang a présenté une feuille de route des prochaines puces (GPU, DPU et CPU), et elle est très ambitieuse. D'ici à 2025, le fournisseur prévoit de sortir six générations de matériel : deux pour Ampere (GPU), deux pour Grace (CPU ARM) et deux pour Bluefield (DPU). Ampere Next est le nom de code de la prochaine génération de GPU, attendue 2022. Selon les spéculations, le produit commercial s'appellera Hopper, poursuivant ainsi la tradition de nommer les architectures GPU d'après les pionniers de l'informatique. Associé au CPU Grace (https://www.lemondeinformatique.fr/actualites/lire-grace-la-puce-hpc-de-nvidia-attendue-en-2023-82589.html), un système Nvidia associant une puce ARM et un GPU maison pourra donc être baptisé Grace Hopper, la légendaire pionnière de l'informatique de la Marine américaine. Ampere Next Next fera ses débuts en 2024 ou 2025.

Issue du rachat de Mellanox, le DPU Bluefield-3 profite de la montée en gamme d'ARM. (Crédit Nvidia)

Grace est prévue pour 2023 et Grace Next pour 2025, tandis que l'unité de traitement de données (DPU) Bluefield héritée de Mellanox connaîtra également deux itérations : Bluefield-3 en 2022 et Bluefield-4 en 2024. Nvidia fait d'énormes déclarations sur les performances. Bluefield-3 sera 10 fois plus rapide que Bluefield-2, et Bluefield-4 pourrait multiplier les performances par 100. Le DPU BlueField-3, qui combine un CPU ARM et un processeur réseau pour décharger le traitement réseau des CPU, est doté de liaisons de 400 Gbit/s et d'une puissance de calcul ARM cinq fois supérieure à celle du DPU actuel. Selon Nvidia, un DPU BlueField-3 fournirait des services pour centre de données équivalents à 300 coeurs x86.

Utilisation de la technologie ARM

Pendant que Nvidia règle les problèmes liés à son projet d'acquisition d'ARM, l'entreprise déploie des efforts considérables pour promouvoir la plate-forme CPU dans tous les domaines. Tout d'abord, la firme a annoncé qu'elle allait fournir une accélération GPU pour le Graviton2 d'Amazon Web Services, le propre processeur ARM de l'opérateur cloud. Les instances accélérées de Graviton2 offriront de meilleures expériences de game-streaming et réduiront le coût des puissantes capacités d'inférence IA.

Du côté des fondeurs, Nvidia travaille avec MediaTek, une des principales entreprises de puces pour smartphones, pour créer une catégorie d'ordinateurs portables animés par un CPU ARM et un GPU Nvidia RTX. Ces ordinateurs portables utiliseront des coeurs ARM et des noyaux graphiques Nvidia pour offrir aux consommateurs des laptops économes en énergie avec des capacités multimédia sans compromis basées sur une plate-forme de référence qui supporte Linux, Chromium et les SDK Nvidia. Et dans le domaine de l'informatique edge, Nvidia travaille avec Marvell Semiconductor pour associer ses processeurs Octeo ARM aux GPU de Nvidia. Ensemble, ils accéléreront les charges de travail IA pour l'automatisation et la sécurité des réseaux.

Suivez-nous