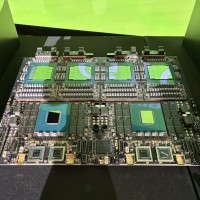

Cette carte mère Nvidia GB300, avec 2 CPU Grace et 4 GPU Blackwell Ultra est montée dans un système GB300 NVL72 (36 puces Grace et 72 GPU Blackwell Ultra). (Crédit S.L.)

Lors de sa GTC 2025, Nvidia a dévoilé de nouvelles avancées en intelligence artificielle, allant des AI factory aux GPU Blackwell Ultra pour datacenters, en passant par des solutions taillées pour les industries. Jensen Huang a présenté ces innovations comme des leviers pour transformer l'IA en moteur clé de nombreux secteurs.

La conférence annuelle de Nvidia, la GTC 2025 (GPU Technology Conference), du 17 au 21 mars à San José (Californie), a rassemblé près de 25 000 personnes (employés, partenaires et clients) pour sa seconde édition en physique depuis la fin de la pandémie. Le fournisseur de Santa Clara a présenté une série d'annonces autour de l'intelligence artificielle, soulignant sa volonté de promouvoir ses solutions dans tous les secteurs industriels avec ses technologies reposant sur ses développements logiciels, ses GPU et ses équipements réseau. Rappelons que Nvidia a réalisé un chiffre d'affaires de 60,9 milliards de dollars en 2024, en hause de 126% par rapport à l'année précédente. En ce qui concerne la répartition entre les activités, l'activité Datacenter - avec les GPU pro - a généré la majeure partie des revenus de Nvidia en 2024. Pour le quatrième trimestre fiscal 2024 (novembre 2023 à janvier 2024), les revenus du segment datacenter ont atteint 18,4 milliards de dollars, soit une augmentation de 409% par rapport à l'année précédente. Ce segment représente la part du lion dans les revenus de Nvidia, principalement grâce à la demande croissante en puces pour l'intelligence artificielle et le cloud computing. Au 4eme trimestre 2024, Blackwell a ainsi généré 11 milliards de revenus selon une source officieuse. Les chiffres exacts pour l'année fiscale 2024 complète ne sont pas directement fournis dans les résultats, mais pour le premier trimestre fiscal 2025 (février à avril 2024), le segment gaming a contribué à environ 10% du chiffre d'affaires total. Bien que Nvidia soit historiquement connue pour ses GPU gaming, cette division représente désormais une part plus faible de ses revenus totaux.

Près de 11 000 personnes selon Nvidia sont venues écouter pendant deux heures le CEO Jensen Huang. (Crédit Nvidia)

Dans son discours d'ouverture du 18 mars au SAP Center à San José, qui accueille habituellement des matchs de hockey, Jensen Huang, CEO et cofondateur de Nvidia, a articulé une vision centrée sur l'accessibilité et l'efficacité, en mettant en avant des solutions spécialisées et une évolution significative des capacités de calcul. Devant une assemblée conquise (près de 11 000 personnes), le dirigeant a souligné l'importance croissante des AI factory, ces datacenters - mais aussi PC AI et serveurs edge en local - repensés et conçus pour produire automatiquement du code, et accélérer le développement logiciel à grande échelle. « Les AI factory vont permettre aux entreprises de démultiplier leur capacité de développement logiciel tout en optimisant leur efficacité opérationnelle », a-t-il expliqué. Grâce à une architecture avancée, ces datacenters disposant de capacité de calcul et d'une bande passante mémoire atteignant plusieurs centaines de térabytes par seconde, assureront une exécution rapide et optimisée des tâches complexes. Un autre élément clé dévoilé lors de cette conférence est Dynamo, présenté comme le système d'exploitation des futures AI factory. En orchestrant dynamiquement les ressources matérielles en fonction des charges de travail, Dynamo facilite la production de tokens d'IA tout en minimisant la latence, explique Nvidia. Jensen Huang a insisté sur son rôle central : « Dynamo est l'épine dorsale des AI factory. Son rôle est d'assurer une efficacité maximale tout en conservant une flexibilité opérationnelle sans précédent. »

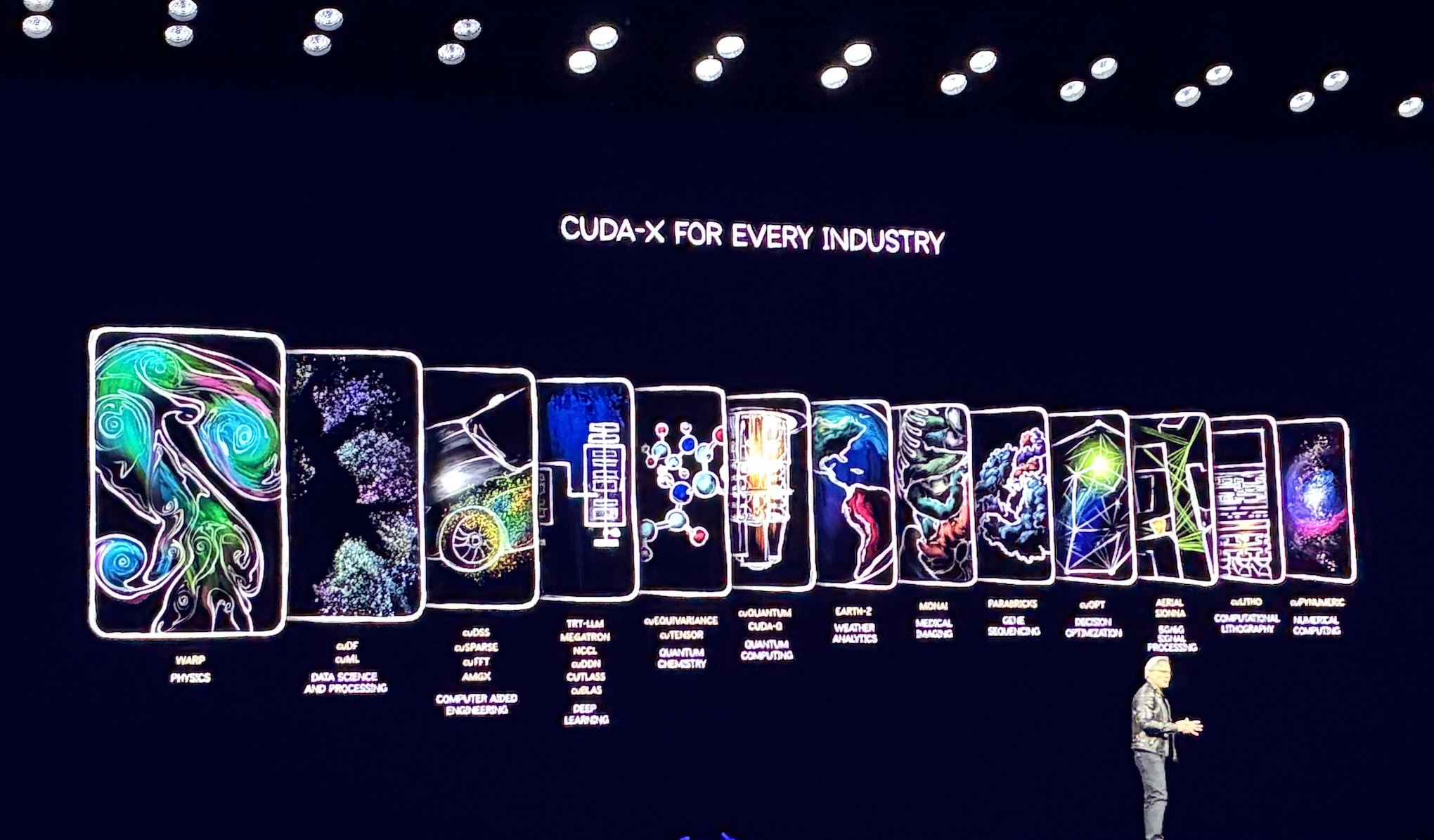

Nvidia distille ses GPU au coeur des principales industries avec des déclinaisons de son framework Cuda. (Crédit S.L.)

Dans cette optique, Nvidia met en avant sa bibliothèque Cuda-X, une suite logicielle optimisée pour différents secteurs industriels, de la santé à la finance en passant par la biologie et le transport. Cette approche permet aux entreprises d'exploiter des cadres spécifiques à leurs domaines pour tirer le meilleur parti des capacités de l'IA. « Cuda-X représente une étape clé pour l'adoption généralisée de l'IA », a commenté le CEO, précisant que chaque industrie bénéficiera de solutions adaptées à ses défis uniques. L'automobile n'est pas en reste avec l'annonce de Halos, un système de conduite autonome plus sécurisée que les propositions actuelles. En combinant modélisation avancée, simulation en boucle fermée et gestion des scénarios complexes, Halos vise à garantir une conduite autonome plus sûre et plus fiable. « Halos établit un nouveau standard en intégrant sécurité et transparence au coeur des véhicules autonomes du futur », a affirmé M. Huang.

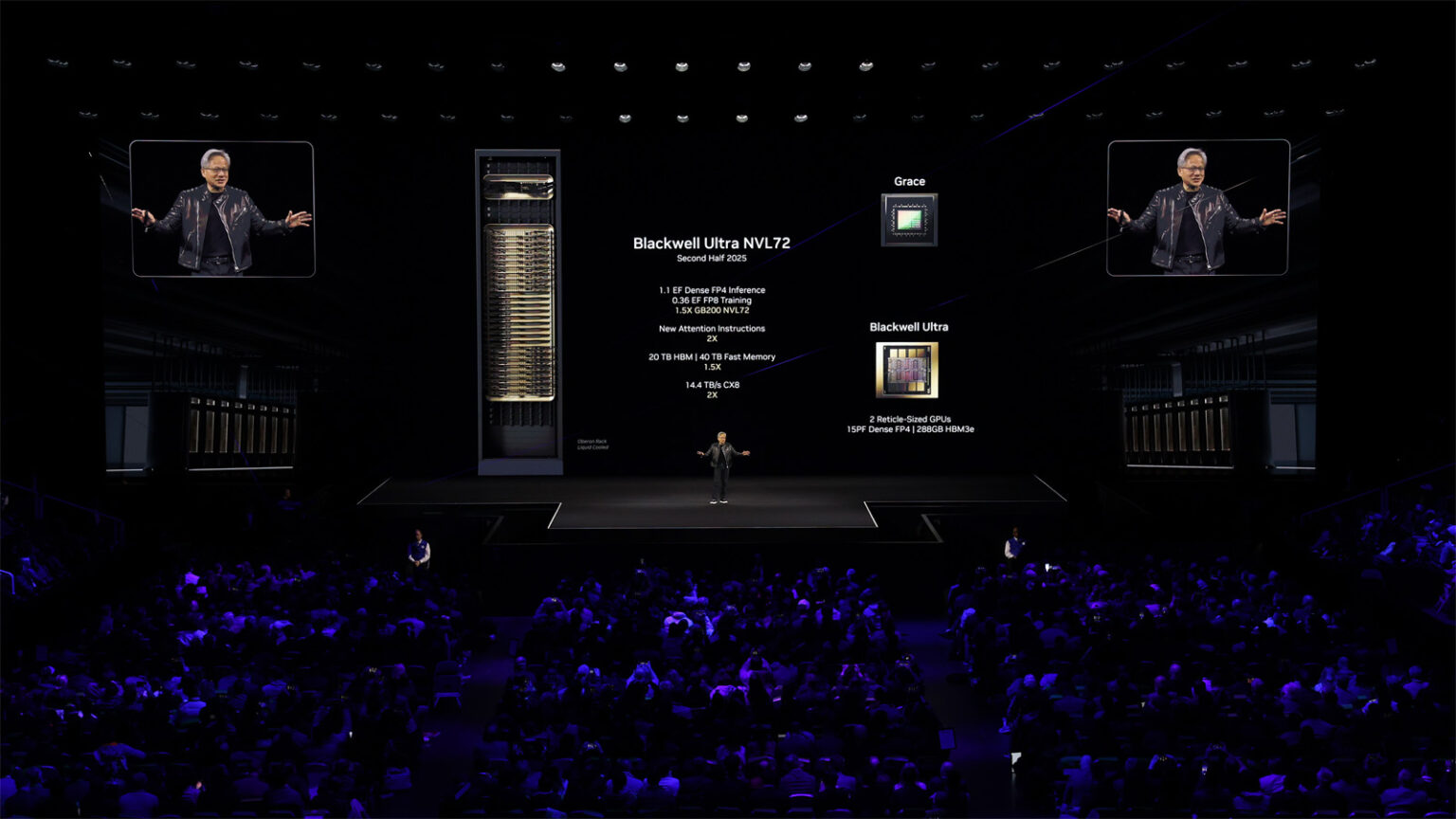

Le lancement de l'architecture GPU Blackwell Ultra, associé aux systèmes HPC GB300 NVL72, aux Blackwell Ultra DGX SuperPod et à une famille de produits Blackwell, marque une étape clef pour le fournisseur. (Crédit: Nvidia)

Mais la partie la plus attendue de la conférence fut sans doute l'annonce du GPU Blackwell Ultra, attendu au second semestre 2025, qui améliore de 25 fois les capacités de calcul de la génération précédente (Blackwell), tout en conservant la même consommation énergétique. Combinant deux GPU de la taille d'un réticule, cet accélérateur, fabriqué en 3 nm chez TSMC, intègre 208 milliards de transistors avec 288 Go de mémoire HBM3e, accompagnée d'une bande passante NVLink de 130 To/s et une connectivité réseau de 14,4 To/s. Selon Jensen Huang, « Blackwell Ultra représente une transition fondamentale dans l'architecture informatique, apportant une réponse directe aux exigences croissantes en calcul intensif et en IA. » Côté performance, l'Ultra fournit 15 pétaflops en FP4. Ces spécifications répondent directement aux besoins en temps réel des applications IA avancées telles que les modèles génératifs et le raisonnement complexe.

Blackwell Ultra est disponible dans la solution en rack GB300 NVL72 (36 puces Grace sur base Arm et 72 GPU Blackwell Ultra), le système HGX B300 NVL16 et dans le Blackwell Ultra DGX SuperPod. Spécifiquement optimisé pour le raisonnement par intelligence artificielle, Jensen Huang décrit le GB300 NVL72 comme un système « conçu pour démocratiser l'accès au raisonnement IA, tout en réduisant drastiquement la consommation énergétique et les coûts associés. » Le GB300 est équipé de 8 modules HBM4 offrant une capacité mémoire totale de 192 Go, avec une bande passante mémoire dépassant 6 To/s, pour assurer une exécution fluide des grands modèles IA. Son architecture multi-GPU permet une interconnexion optimisée via NVLink pour les 72 GPU, offrant une latence réduite et une scalabilité accrue. Ce serveur affiche des performances en hausse en comparaison des systèmes précédents utilisant les GPU H100 : la vitesse de génération de tokens est ainsi améliorée, passant de 100 à 1000 tokens par seconde. Les temps nécessaires à la résolution de tâches complexes sont aussi réduits, passant de 1,5 minute à seulement 10 secondes. « Ces améliorations positionnent le système GB300 NVL72 comme un nouvel étalon pour les infrastructures IA dédiées à des opérations de raisonnement à grande échelle », explique Nvidia.

Comme son nom l'indique, le DGX B300 NVL16 accueille 2 processeurs Intel Xeon et 16 puces Blackwell Ultra pour une capacité de calcul de 105 pétaflops en FP4. Chaque GPU est connecté à un domaine NVLink de 16 GPU à 1,8 To/s, ce qui représente 2,3 To de mémoire HBM3e par système. Avec le SuperPod DGX Blackwell Ultra, Nvidia propose une solution complète, clé en main, destinée aux entreprises cherchant à construire des « AI factories ». Selon Jensen Huang, « ces SuperPods fournissent une puissance extrême, capable de supporter les plus vastes et exigeants modèles IA actuellement développés. » Le DGX SuperPod Blackwell Ultra inclut ainsi 288 puces Grace et 576 GPU Blackwell Ultra, délivrant une puissance de calcul cumulée atteignant 11,5 exaflops en FP4. Grâce à son architecture modulaire et à son refroidissement optimisé par air, le SuperPod assure une intégration facile au sein des centres de données existants tout en apportant des performances de pointe.

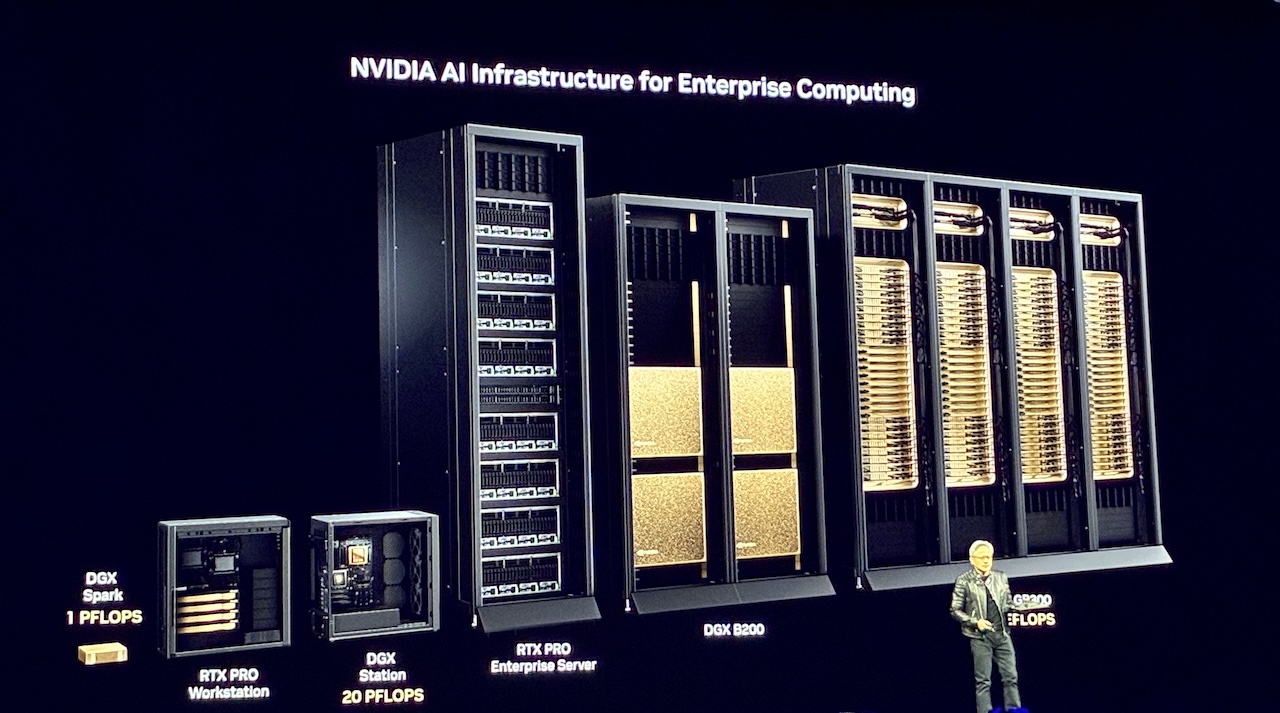

De simple spécialiste des cartes 3D, Nvidia est devenu un fournisseur de solutions HPC et IA pour les entreprises et les hyperscalers. (Crédit S.L.)

De simple spécialiste des cartes 3D, Nvidia est devenu un fournisseur de solutions HPC et IA pour les entreprises et les hyperscalers. (Crédit S.L.)

Une famille élargie autour de Blackwell

Nvidia ne limite pas ses innovations aux seuls systèmes HPC. L'entreprise étend l'architecture Blackwell à une large gamme de produits afin de couvrir divers segments du marché avec le GB10 DGX Spark, un mini-PC HPC permettant une démocratisation du calcul haute performance, en facilitant l'intégration de l'IA dans des environnements restreints ou à budgets limités, les laptops et stations de travail RTX Blackwell, et les serveurs DGX GB300 et B300 NVL16. Lors de son allocution, Jensen Huang a souligné l'importance stratégique de ces solutions, en indiquant : « Les besoins en puissance de calcul liée à l'IA, particulièrement pour le raisonnement, sont aujourd'hui cent fois supérieurs à ceux de l'année précédente. »

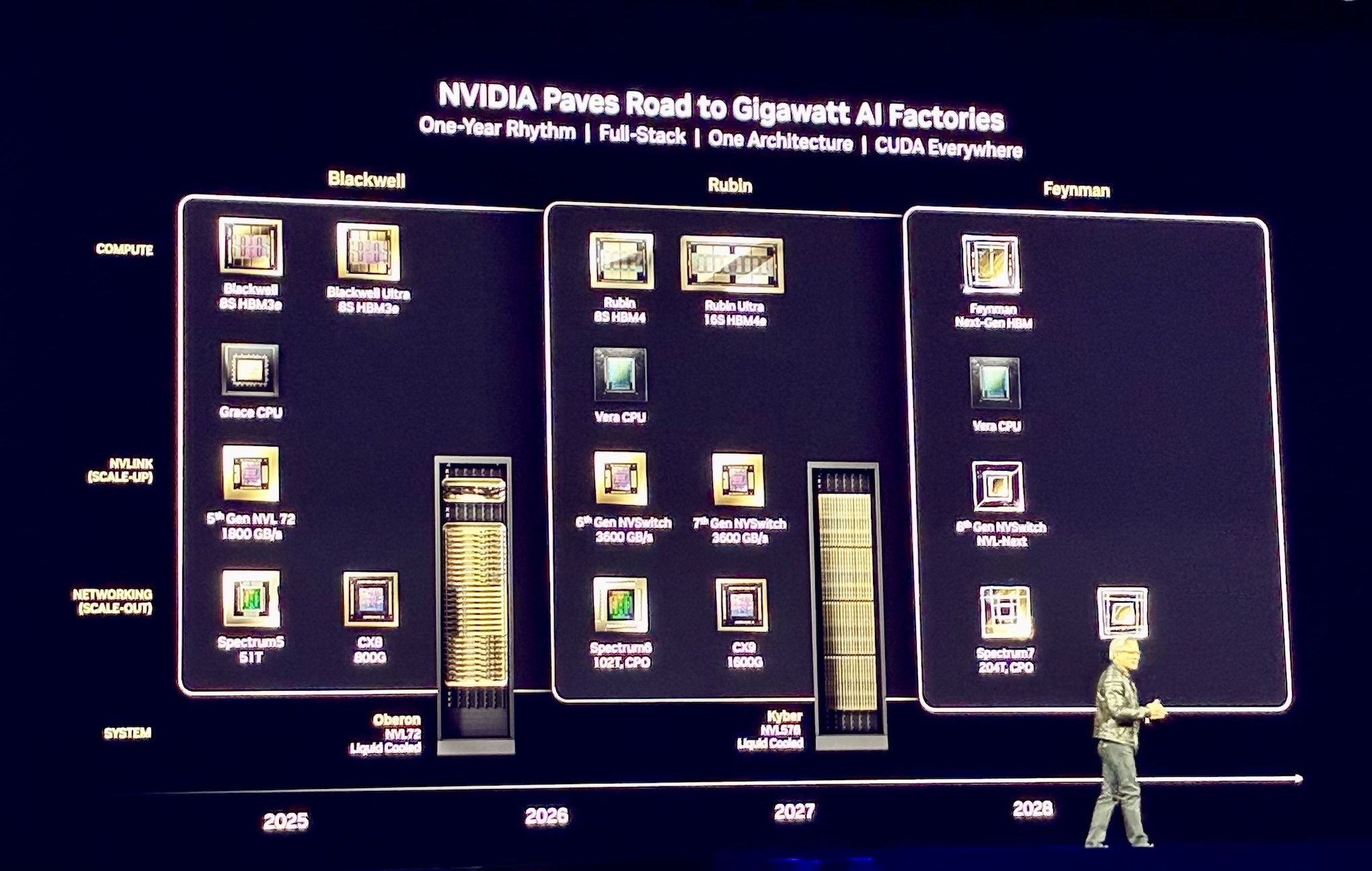

Jensen Huang a présenté une feuille de route bien fournie jusqu'en 2028 pour les GPU, les CPU et le réseau. (Crédit S.L.)

Jensen Huang a présenté une feuille de route bien fournie jusqu'en 2028 pour les GPU, les CPU et le réseau. (Crédit S.L.)

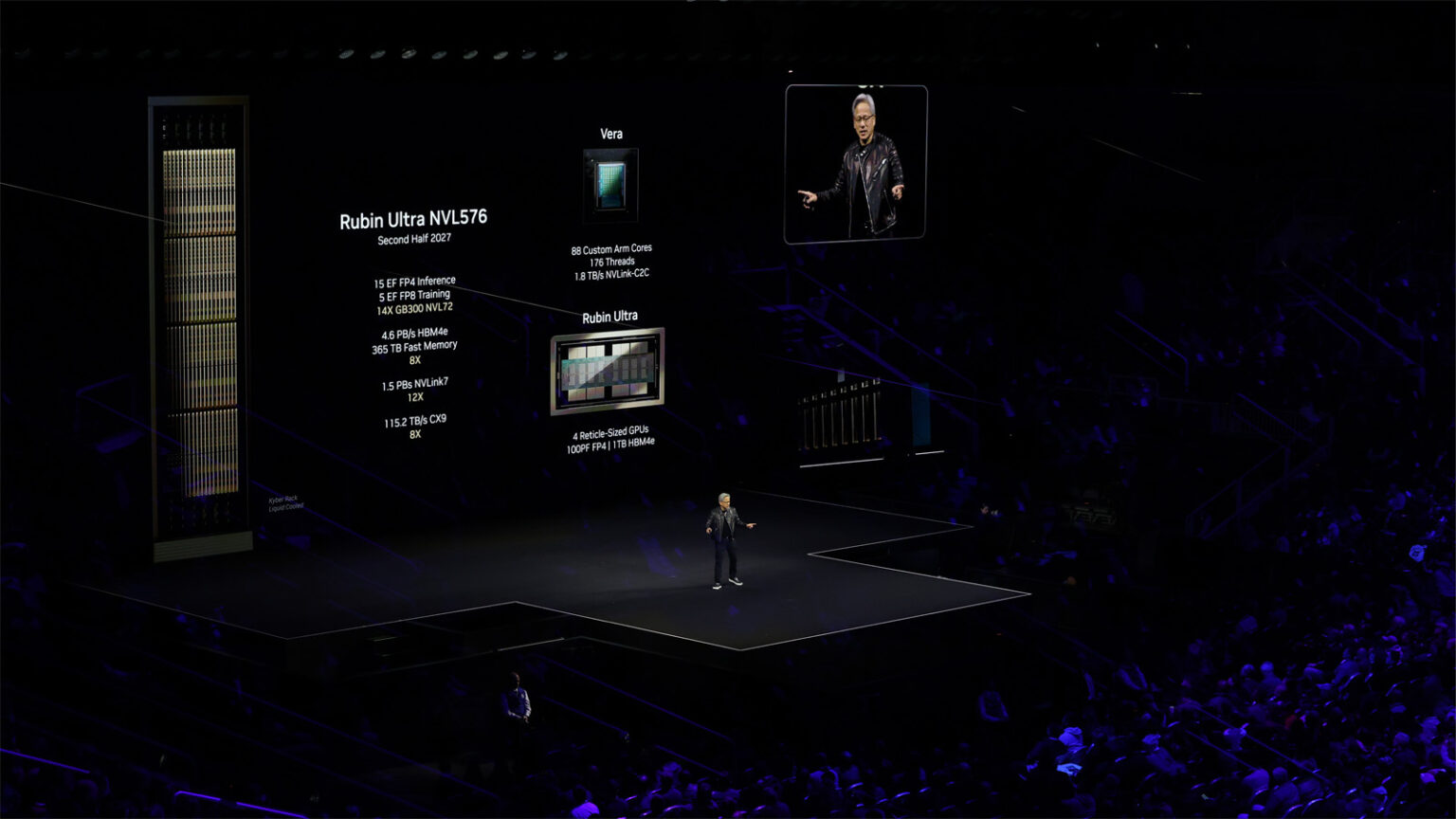

En clôture de la conférence, Nvidia a dévoilé sa feuille de route pour les années à venir, introduisant les puces Vera et les GPU Rubin, prévus pour 2026, ainsi que Rubin Ultra, attendu en 2027. Ces architectures promettent une augmentation significative des performances en IA, afin d'accompagner les grands projets chez les hyperscalers et les grands comptes. « Avec Vera et Rubin, nous nous engageons à soutenir une croissance continue des capacités IA », a conclu Jensen Huang.

Le successeur du Blackwell Ultra a déjà été présenté : le Rubin Ultra, attendu en 2027. (Crédit Nvidia)

À travers ces annonces, Nvidia confirme son ambition de structurer le futur technologique des industries en rendant l'intelligence artificielle toujours plus accessible et performante. En proposant un éventail complet de solutions allant du mini-PC aux supercalculateurs, le fournisseur de Santa Clara se positionne à la pointe du calcul. Selon Jensen Huang, « ces innovations vont permettre d'accélérer significativement le développement et l'adoption de solutions IA dans tous les secteurs de l'industrie mondiale. »

Suivez-nous