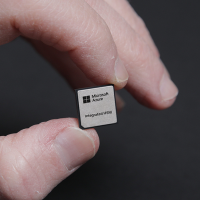

Les fournisseurs de cloud, comme Microsoft avec l'Azure Boost DPU, se tournent vers les puces personnalisées pour répondre à la forte demande. (Crédit Microsoft)

Face à la pénurie de GPU, les fournisseurs de cloud se tournent de plus en plus vers des puces personnalisées pour traiter des charges de travail spécifiques et offrir des capacités de calcul plus rentables.

Coincés entre la demande de calcul toujours plus rapide induite par l'IA et la pénurie de GPU qui servent à accélérer ces charges de travail, les hyperscalers conçoivent du silicium personnalisé pour des charges de travail spécifiques, afin d'améliorer encore les performances tout en réduisant les coûts. Lors de sa conférence Ignite (19 au 21 novembre), Microsoft a ajouté deux puces aux déjà nombreuses instances matérielles de son catalogue cloud, et désormais, tous les regards sont tournés vers AWS pour voir si, lors de son événement Re :invent de cette semaine (2 au 6 décembre), le fournisseur fera des annonces de puces personnalisées. Certaines tâches informatiques, comme l'entraînement et l'exécution de modèles d'IA, peuvent être accélérées en les exécutant sur des GPU plutôt que sur des CPU. Mais ce n'est pas le cas de toutes les tâches. C'est la raison pour laquelle, en plus de remplir leurs centres de données avec des GPU de fabricants comme Nvidia et AMD, les fournisseurs de services de cloud développent leurs propres puces pour accélérer les performances de tâches spécifiques. « Même si, à n'en pas douter, les GPU ont révolutionné les charges de travail à haute performance comme la modélisation, la simulation, la formation et l'inférence dans l'IA et l'apprentissage machine (ML), ils sont gourmands en énergie et nécessitent un refroidissement supplémentaire », a expliqué Mario Morales, analyste vice-président du cabinet d'études IDC.

D'autant que la production de GPU est insuffisante, obligeant des fabricants de puces comme Nvidia, AMD et Intel, à augmenter leur capacité et à produire de nouveaux processeurs. En octobre, les analystes de Morgan Stanley ont constaté que les derniers GPU Blackwell de Nvidia étaient réservés pour une période d'environ 12 mois. Selon M. Morales, les progrès récents ont créé des alternatives pour les acheteurs d'IT et les fournisseurs de services, notamment sous forme d'accélérateurs personnalisés. « Ces accélérateurs jouent un rôle de plus en plus important dans l'infrastructure cloud en raison de leur rapport prix-performance et prix-efficacité supérieur, et donc d'un meilleur retour sur investissement », a-t-il déclaré.

L'intérêt de Microsoft pour les puces personnalisées s'est manifesté bien après ses concurrents. Cela fait des années que ses rivaux ont introduit des puces personnalisées pour les charges de travail d'IA, AWS avec Trainium et Inferentia, et Google avec ses Tensor Processing Units (TPU). Ce n'est que lors de la conférence Ignite de l'an dernier que Microsoft a dévoilé ses premières puces personnalisées, Maia et Cobalt, pour s'attaquer aux charges de travail d'IA internes et rendre ses centres de données plus efficaces sur le plan énergétique.

Accélérer les flux de données d'IA avec des DPU

Lors du dernier événement Ignite, Microsoft a présenté deux autres puces : l'Azure Boost DPU pour accélérer le traitement des données, et le module Azure Integrated HSM pour améliorer la sécurité. Le DPU Azure Boost est un co-design matériel-logiciel, spécifique à l'infrastructure Azure, qui exécute un système d'exploitation de flux de données léger et personnalisé qui, selon Microsoft, permet des performances plus élevées, une consommation d'énergie plus faible et une efficacité accrue par rapport aux implémentations traditionnelles. L'éditeur a également présenté une version de son rack sidekick à refroidissement liquide pour la prise en charge de serveurs exécutant des charges de travail d'IA, ainsi qu'un rack d'alimentation désagrégé co-conçu avec Meta. Selon Microsoft, il pourra intégrer 35 % d'accélérateurs d'IA de plus dans chaque rack de serveur.

« Nous prévoyons que les futurs serveurs équipés de DPU exécuteront des charges de travail de stockage dans le cloud en consommant trois fois moins d'énergie et en offrant des performances quatre fois supérieures à celles des serveurs existants », a écrit l'entreprise dans un billet de blog. Cependant, selon Alvin Nguyen, analyste principal chez Forrester, Microsoft ne fait que rattraper son retard dans le domaine des DPU. L'analyste a comparé le DPU Azure Boost de Microsoft avec l'IPU E2000 de Google, développé conjointement avec Intel. De même, AWS propose son système Nitro pour les tâches orientées DPU. D'autres fournisseurs de services cloud utilisent Nvidia Bluefield et AMD Pensando pour ces applications.

Un silicium personnalisé pour la sécurité

La sécurité est un autre domaine dans lequel le silicium personnalisé peut offrir de meilleures performances. Microsoft affirme que son module HSM intégré Azure permettra aux clés de cryptage et de signature de rester dans les limites du matériel sans compromettre les performances. M. Nguyen a expliqué que la puce remplit une fonction très spécifique qui serait autrement gérée par une combinaison de matériel et de logiciel, avec une plus grande exposition aux attaques et un plus grand impact sur les performances, ce qui la rend sujette à la latence et donc plus difficile à mettre à l'échelle. D'autres fournisseurs de services cloud, comme AWS et Google, bien que différents dans leur mise en oeuvre, proposent aussi des puces axées sur la sécurité comme la puce Nitro d'AWS et la puce Titan de Google.

« Alors que Nitro assure une fonction de sécurité critique en garantissant que les processeurs du système principal ne peuvent pas mettre à jour le micrologiciel en mode « bare metal », Titan fournit une racine de confiance matérielle qui établit l'identité forte d'une machine, avec laquelle nous pouvons prendre des décisions de sécurité importantes et valider la santé du système », a fait valoir M. Nguyen. Les analystes pensent que les hyperscalers vont introduire davantage de silicium personnalisé pour s'attaquer à d'autres charges de travail ou essayer d'être plus efficaces. « Une fois acquise la capacité coûteuse de fabriquer des puces personnalisées, il est logique de chercher où l'on peut dégager le plus de marge pour les fournisseurs, où la croissance est la plus rapide, et de l'appliquer », a estimé Alexander Harrowell, analyste principal chez Omdia.

Suivez-nous