Un des châssis de Liqid capable d'accueillir 10 cartes PCie 4.0 en attendant l'arrivée des serveurs CXL supportant le PCie 5.0 (Crédit S.L.)

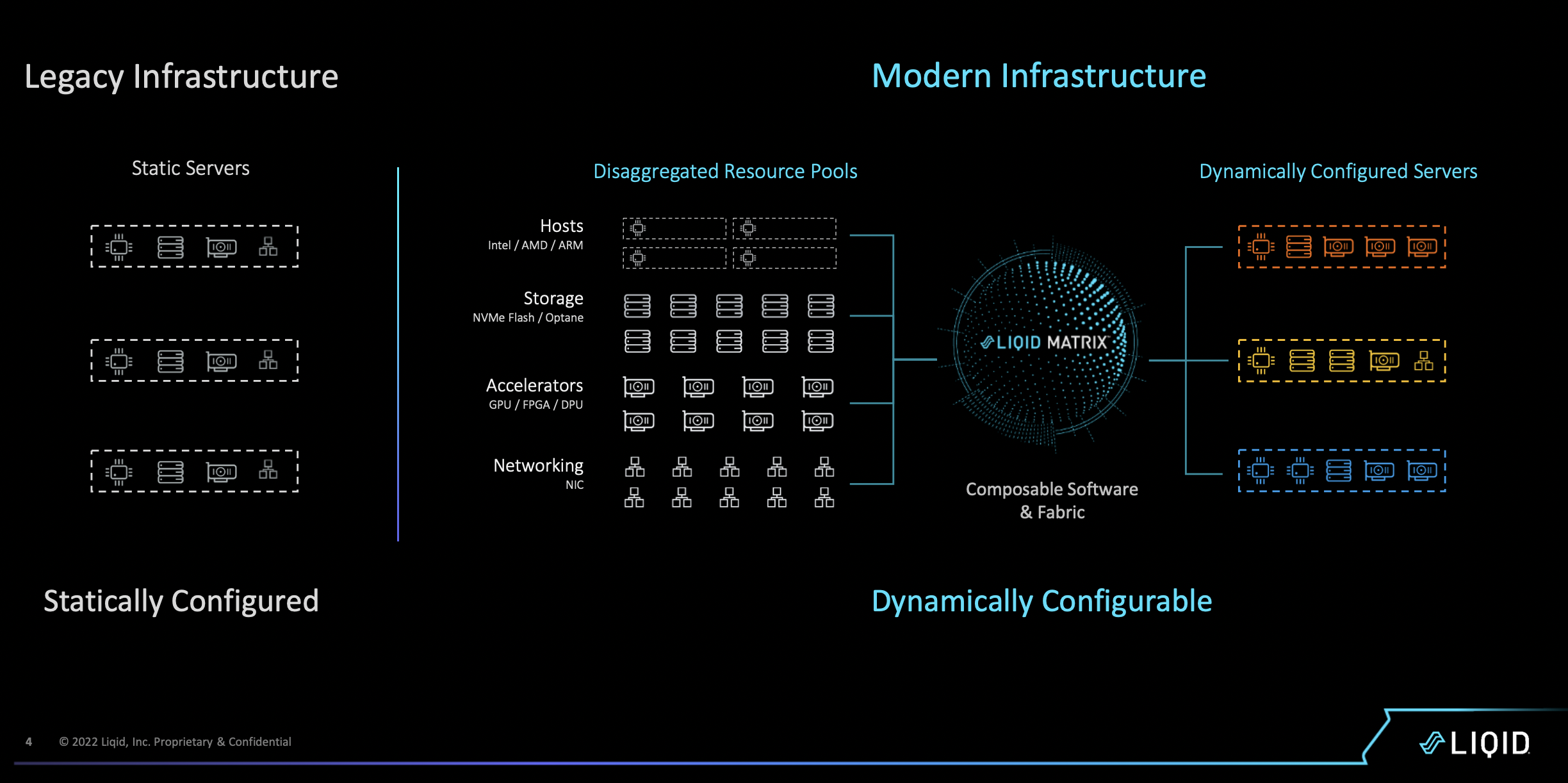

Avec sa plateforme Matrix Fabric, Liqid propose d'attribuer dynamiquement des ressources GPU, DPU, FPGA, SSD NVMe flash et Optane, des SmartNic - Ethernet et Infinband avec Nvidia Bluefield par exemplre - et désormais de la mémoire RAM et persistante pour épauler des traitements exigeants.

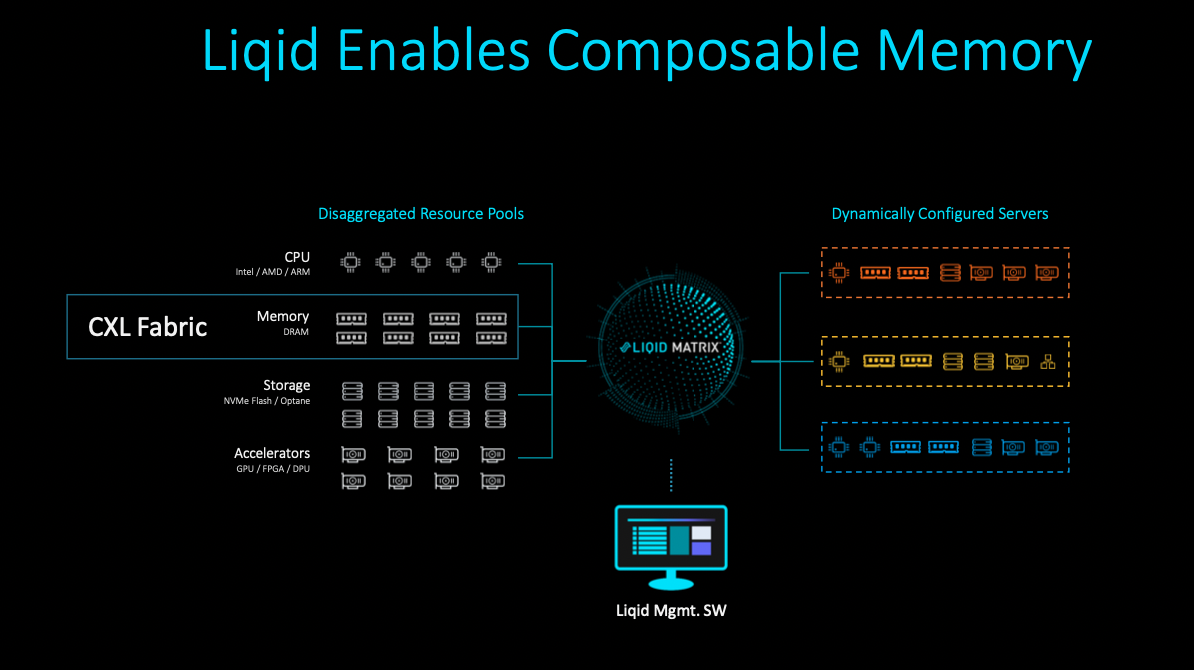

Précurseur sur le marché des infrastructures composables ou désagrégées avec son concurrent Fungible, Liqid poursuit le développement de sa plateforme Matrix. Après des entretiens en visioconférence pour cause de pandémie, nous les avons enfin rencontrés sur place dans le cadre du dernier IT Press Tour début juin 2022. Après les GPU, les DPU, les FGPA et le stockage flash, la start-up installé à Broomfieed, près de Denver dans le Colorado, ajoute la gestion de la DRAM et de la SCM (storage class memory) à ses châssis désagrégés avec le support du protocole d'interconnexion CXL sur PCIe 5.0. Pour supporter la mémoire, Liqid fait appel à la technologie BigMemory de MemVerge combinant DRAM et Dimm Optane dans un seul pool en cluster pour les applications. La prise en charge de la mémoire était très attendue chez les clients qui piochent en fonction de leurs besoins en HPC, compression vidéo et IA des capacités additionnelles sur les châssis Liqid. « Les solutions basées sur Intel Optane de MemVerge et Liqid fournissent des vitesses de données proches de la mémoire pour les applications qui doivent maximiser la puissance de calcul pour extraire efficacement des informations exploitables du déluge de données en temps réel », nous a indiqué Ben Bolles, directeur produit chez Liqid.

La plateforme Matrix de Liqid pour exploiter d'une manière dynamique les ressources matérielles d'un pool de serveurs. (Crédit S.L.)

Liqid propose plusieurs types de châssis : l'EX 4400 - un serveur x86 4U en fait fourni par Dell, HP, Lenovo ou Supermicro - pour accueillir les cartes PCIe (10 ou 20 slots suivant le modèle), une sorte de Jbod (32 baies) pour les SSD (flash et Optane), et un module dédié pour la mémoire persistante développé avec Intel (Composable Memory Kit) sans oublier les switchs fabric PCIe pour agréger les ressources. Un châssis CXL, avec le support de l'interface PCIe 5.0 est encore attendu. Associés au logiciel d'orchestration et à la fabric Ethernet de la start-up, ces châssis partagent ensuite sur le réseau IP les ressources des cartes PCI GPU, DPU ou FPGA, de SSD NVMe/Optane et de la mémoire persistante avec des grappes de serveurs. Le moteur d'orchestration pilote finement l'allocation des capacités disponibles en fonction des workloads. Précisons que les SSD ne sont accessibles que par un seul pool de serveurs. Les ressources composables sont disponibles pour des serveurs bare-metal, mais également des VM et des containers. GPU, DPU, FPGA et flash sont combinables dans le châssis Liqid. « Mais les plus grandes opportunités sont aujourd'hui du côté des GPU », nous a indiqué le CEO de Liqid Sumit Puri.

Le support de la DRAM est attendu avec l'arrivée des châssis équipés de l'interface CXL avec le protocole PCIe 5.0. (Crédit S.L.)

Un plug-in vCenter pour créer et gérer un pool composable Liqid

« Notre datacenter dynamique permet des économies par rapport aux solutions cloud pour un usage intensif des CPU et des GPU », assure Sumit Puri. « Le premier usage chez nos clients est l'allocation et le partage des GPU, DPU, FHPS et autres SmartNIC. Nous connaissons un gros succès dans le HPC ». La réorganisation des ressources pour alimenter des nouveaux projets est également mise en avant par la start-up. « La reconfiguration des constructions est dynamique, il suffit de 10 secondes pour réallouer des GPU sans redémarrer le serveur », a ajouté le CEO. Les GPU travaillent directement sans passer par les processeurs afin de réduire la latence (25 à 30 ns) et améliorer la quantité de bande passante exploitable. Précisons que Liqid travaille en mode peer-to-peer (ioDirect) pour son data flow. « Quand un projet démarre chez un client, il peut être nécessaire de mobiliser tous les GPU disponibles, pour ensuite les réattribuer progressivement ».

Lors de notre point presse, Liqid a d'ailleurs mis en avant la disponibilité de son plug-in pour vCenter pour directement créer et gérer un pool composable Liqid depuis la console de VMware. Si vSphere est le premier hyperviseur pris en charge par Liqid, d'autres sont à venir : KVM et Hyper-V par exemple. Un client français, Orange pour ne pas le citer, est d'ailleurs venu tester la solution avec des GPU Nvidia pour assurer des traitements deep learning.

Suivez-nous