Avec l'expertise de Cray, HPE propose des systèmes de refroidissement pour ses serveurs x86 Proliant. (Crédit HPE)

Pour répondre aux besoins des dernières puces d'AMD, Intel et Nvidia, la dernière architecture de HPE pour les racks et les serveurs s'affranchit des ventilateurs, et la solution en rack de Supermicro a été spécialement conçue pour la plateforme Blackwell de Nvidia.

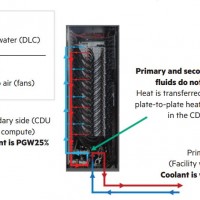

Hewlett Packard Enterprise (HPE) et Supermicro ont chacune annoncé des produits de refroidissement liquide pour serveurs x86 pour parer aux émissions de chaleur générées par les CPU et autres accélérateurs GPU nécessaires aux déploiements d'IA à grande échelle. La conception présentée par HPE est basée sur un système de refroidissement liquide direct qui se passe de ventilateurs, un élément toujours coûteux. Le refroidissement par liquide s'effectue de trois manières : des refroidisseurs ou des réfrigérants qui refroidissent les tuyaux à mesure que le liquide chaud les traverse ; des ventilateurs qui soufflent sur le tuyau, sans produire d'air froid, ce qui consomme moins d'énergie, mais ne refroidit pas l'eau autant que les refroidisseurs ; et la simple dissipation de la chaleur qui permet au liquide de se refroidir naturellement à mesure qu'il se déplace le long du tuyau. La seconde méthode est assez courante. Le liquide chaud qui circule dans les tuyaux en s'éloignant de l'unité centrale peut être refroidi de manière adéquate en combinant la dissipation naturelle de la chaleur et le maintien des tuyaux au frais grâce à des ventilateurs, un peu comme le fonctionnement des radiateurs de voiture. Sauf qu'il faut un nombre impressionnant de ventilateurs qui consomment beaucoup d'énergie et occupent beaucoup de place.

La dernière architecture de HPE ne fait pas appel à des ventilateurs : le système de refroidissement repose sur 8 éléments qui couvrent divers composants du serveur comme la lame de serveur, le fabric de réseau et l'unité de distribution du liquide de refroidissement (Coolant Distribution Unit, CDU). La conception n'est pas nouvelle, puisque cela fait un certain temps que HPE utilise cette technologie dans ses superordinateurs Cray EX. L'entreprise l'étend aujourd'hui à d'autres systèmes autres que des supercalculateurs. HPE affirme que cette approche permet de réduire de 50 % l'espace requis dans les centres de données et de 37 % la puissance de refroidissement nécessaire par lame de serveur. « Les entreprises adoptent largement et rapidement l'IA générative, et dans le même elles doivent aussi faire évoluer leurs objectifs de durabilité, limiter leurs besoins toujours plus grands en énergie et réduire leurs coûts opérationnels. L'architecture dévoilée aujourd'hui n'utilise que le refroidissement liquide, ce qui offre des avantages plus importants en termes d'efficacité énergétique et de rentabilité que les solutions alternatives de refroidissement hybride du marché », a affirmé Antonio Neri, président et CEO de HPE, dans un communiqué.

Une offre de refroidissement liquide chez Supermicro

Selon la présentation du fabricant de serveurs Supermicro, son dernier produit apporte une « solution complète de refroidissement liquide ». L'offre comprend des CDU, des plaques froides, des collecteurs de distribution de liquide de refroidissement (Coolant Distribution Manifold, CDM), des tours de refroidissement et un logiciel de gestion de bout en bout. Les plaques froides de la solution de Supermicro dissipent jusqu'à 1 600 W, ce qui est suffisant pour refroidir les puces Nvidia les plus chaudes. Quant aux SuperClusters refroidis par liquide de Supermicro, ils sont spécialement conçus pour la plate-forme NVL72 GB200 Grace Blackwell Superchip de Nvidia, laquelle combine un CPU et deux GPU Blackwell sur une seule carte. Les clusters sont équipés d'unités de distribution de liquide de refroidissement en rack ou en rangée et des plaques froides personnalisées conçues pour le compute tray abritant deux cartes GB200 dans un facteur de forme 1U. La solution en rack incorpore jusqu'à 72 GPU Blackwell et 36 CPU Grace, interconnectés par le réseau NVLink de Nvidia, qui peut gérer jusqu'à 130 térabits par seconde (TB/s) de communication GPU totale avec une latence extrêmement faible et des performances améliorées. Ces solutions de refroidissement sont en cours d'échantillonnage auprès de clients sélectionnés en vue d'une production à grande échelle à la fin du quatrième trimestre de cette année.

Suivez-nous