Michael Dell, CEO de Dell Technologies a dévoilé l'AI Factory pour accompagner les entreprises dans leur stratégie IA. (Crédit Photo : JC)

Autour d'une IA Factory, Dell Technologies combine infrastructures, services et écosystème pour accompagner les clients dans leur stratégie IA. Sur le premier volet, le fournisseur présente des produits taillés pour cette technologie.

En direct de Las Vegas. Plus de 7 000 personnes se sont données rendez-vous au Dell Technologies World qui se tient actuellement à Las Vegas avec une teinte un peu particulière, car la société fête ses 40 ans d'existence. Si en 2023, le fournisseur avait évoqué superficiellement l'IA, l'édition 2024 est pleinement focalisée sur cette technologie. Pour Michael Dell, « nous sommes entrés dans l'âge de l'IA » tout en reconnaissant que « la demande en IA est sans précédent aussi bien pour les entreprises que pour les administrations ».

Cette révolution n'est cependant pas sans poser quelques interrogations aux entreprises « par où commencer ? Quels sont les outils ? Comment passer à l'échelle ? Aller sur le cloud ou sur site ? ». La réponse de Dell a ses problématiques est l'AI Factory. A travers ce concept, le fournisseur combine différentes briques (infrastructure, services et écosystème IA) pour accompagner les clients dans leur stratégie IA en partant de la data « l'essence de la fusée IA », souligne Michael Dell.

Un stockage scale out taillé pour l'IA

La première brique dévoilée est l'infrastructure comprenant à la fois du stockage, des serveurs et du réseau. Sur la partie stockage, Dell met à jour sa gamme scale-out PowerScale 100% flash avec la série F910. Sous format 2U, le système embarque 24 lecteurs NVMe et peut accueillir de 92 à 737 To de capacité brute en noeud et 1,87 Po brute en cluster. Côté processeur, la baie adopte les Xeon Sapphire Rapids d'Intel et le PCIE Gen 5. Elle est motorisée par la dernière version de l'OS OneFS 9.8 en apportant RDMA pour NFS v4.1, APEX File Storage pour Azure, et le routage basé sur la source pour les réseaux IPv6. Elle sera disponible à partir de la fin mai.

PowerScale F910 peut comprendre 24 médias NVMe. (Crédit Photo: Dell)

Dell oriente clairement la F910 autour des workload IA. Il avait déjà dévoilé cette orientation en décembre dernier sur sa gamme PowerScale en les certifiant pour être utilisés avec les DGX SuperPod de Nvidia. Dans cette stratégie, le fournisseur a également annoncé le projet Lightning comme étant le futur système de fichiers parallèles. Le nom n'est pas nouveau, car Dell ressuscite un ancien projet éponyme présenté par EMC en 2011 qui s'appuyait une carte PCI express pour serveur capable d'accélérer les échanges d'entrées/sorties entre le serveur et les solutions de stockage. Ce projet évolue pour permettre aux noeuds de cluster PowerScale d'effectuer des I/O en parallèle. « Il peut atteindre une saturation du réseau de 97 % tout en desservant des milliers d'accélérateurs GPU », a expliqué Varun Chhabra, vice-président senior du marketing produit pour la branche ISG de Dell. Le dirigeant n'a pas cependant pas donné plus de détails sur ce projet, ni de date de sortie. Il entre en concurrence avec Lustre, mais aussi des sociétés comme Weka, Vast Data, DDN,...

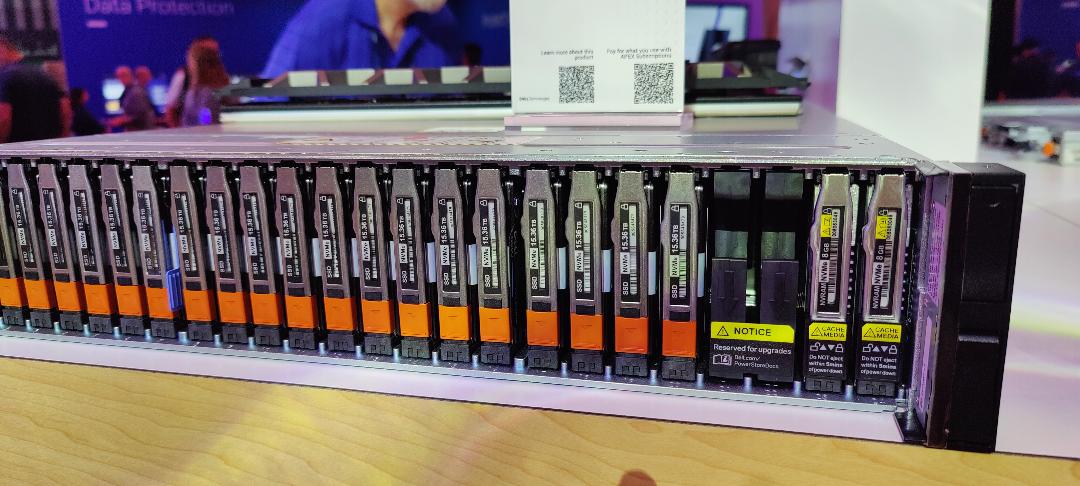

En complément de PowerScale, Dell en profite pour rafraîchir sa gamme PowerStore en lui accolant le terme de Prime. Celui-ci combine des évolutions matérielles et logicielles. Sur le premier point, les baies 3200Q se voit doter de flash nand QLC pouvant atteindre une capacité total de 5,9 Po. Par ailleurs, le fournisseur présente PowerStoreOS 4.0, la dernière version de son système d'exploitation qui augmente les performances de la baie jusqu'à 30 % et ses capacités de réduction des données jusqu'à 20 %. D'autres fonctions concernent la protection des données, notamment la réplication synchrone pour les workload de type bloc et fichier et la réplication métro native pour les environnements Windows, Linux et VMware.

Le PowerStore 3200q embarque des lecteurs flash QLC. (Crédit Photo: JC)

Un serveur dédié aux GPU B200 de Nvidia

Sur la partie serveur, Dell renforce son lien avec Nvidia en présentant le PowerEdge XE9680L capable d'intégrer 8 GPU Blackwell récemment dévoilé à la GTC. De format 4U, cette version ajoute quelques éléments par rapport à la configuration d'origine. Ainsi, il comprend 12 slots PCIe Gen 5 contre 10 précédemment, sur la partie réseau, les capacités nord/sud ont été doublées et le support du 400G Ethernet, Infiniband et Bluefield a été ajouté. Autre élément et non des moindres, le serveur est doté d'un système de refroidissement liquide direct. Jeff Clarke, COO de Dell Technologies avait en mars dernier expliqué aux analystes financiers que les GPU B200 consommaient « 1000 watts par GPU » et que le refroidissement liquide était un passage obligé. Le serveur sera disponible au second semestre 2024.

Le PowerEdge XE9680L va accueillir les GPU B200 de Nvidia et un système de refroidissement liquide. (Crédit Photo : Dell)

Dell annonce également une série de serveurs rackables clés en main, denses et économes en énergie, dont un modèle refroidi par air prenant en charge 64 GPU dans un rack et une option par refroidissement liquide contenant 72 GPU Blackwell. Toujours avec Nvidia, Dell dynamise sa plateforme d'orchestration des environnements edge avec des capacités IA comme l'analyse vidéo via Metropolis ou les capacités de traduction via Riva sans oublier la possibilité de déployer des modèles d'IA via NIM (Nvidia Inference Microservices).

Un commutateur optimisé IA et des PC IA dévoilés

La problématique du réseau est couverte avec un commutateur taillé pour l'IA. Le PowerSwitch Z9864F-ON au format 2U embarque le chipset Tomahawk 5 de Broadcom, capable de gérer une capacité de 51,2 To/s sur des ports 400G Ethernet et de s'adapter à des milliers de noeuds GPU, précise le fournisseur. Il supporte RoCEv2 (Remote Direct Memory Access over Converged Ethernet), mais aussi d'autres protocoles RDMA émergents. Rappelons que cette technologie permet l'accès entre la mémoire principale de deux systèmes sans impliquer de système d'exploitation, de cache ou de stockage. Les données sont ainsi transférées avec un débit élevé, une faible latence et une faible utilisation du CPU. Le Tomahawk 5 introduit également un routage cognitif avancé, un équilibrage de charge dynamique et des capacités de contrôle de la congestion de bout en bout.

Le PowerSwitch Z9864F-ON embarque le chipset Tomahawk 5 de Broadcom. (Crédit Photo : JC)

Au sein de cette brique infrastructure, il faut ajouter les PC AI dévoilés par Dell avec notamment plusieurs terminaux équipés de puces Snapdragon X Elite et X Plus de Qualcomm dotées de NPU (Neural Processing Unit). Une annonce faite en parallèle de celle faite par Microsoft lors de son évènement Build sur Copilot + comprenant plusieurs fonctions IA comme Recall pour rechercher des informations sur une timeline interactive ou Live Captions avec des sous-titres générés par l'IA pour les flux audio et Cocreator, intégrant la GenAI dans Paint. Le constructeur texan aligne pas moins de 5 portables équipés des puces Qualcomm dans les gammes Latitude, Inspiron et XPS. « A travers la conception ARM, Qualcomm dispose d'une très grande autonomie et d'une puissance par watt très efficace », constate Jeff Clarke.

Plusieurs PC AI ont été présentés par Dell dont des terminaux équipés de puces Qualcomm. (Crédit Photo : Dell)

Au final, l'AI Factory se veut complète en partant du PC pour aller du serveur au stockage en passant par le réseau. Un élément différentiant par rapport au concurrent HPE qui a dévoilé en décembre dernier son architecture AI native.

Suivez-nous