Toujours gravées en 14 nm, les puces Xeon Cooper Lake-SP travaillent avec un jeu de composants Intel C620A. (Crédit : Intel)

Et de trois. Intel lance la troisième génération de processeurs Xeon Scalable sur base Cooper Lake-SP (4 et huit voies), optimisée pour le développement de ressources IA et de l'apprentissage automatique. En complément, le fondeur met à profit le rachat d'Altera pour commercialiser son FPGA Stratix 10 NX et pousse toujours ses mémoires Optane.

Avec ses processeurs Xeon Scalable Copper Lake de troisième génération, Intel vient répondre aux besoins des entreprises et des fournisseurs de services cloud avec une plateforme taillée pour l'apprentissage machine, la densification du nombre de VM, les charges de travail analytiques intensives, et les bases de données en mémoire accélérées ou pas par GPU, nos a expliqué Lisa Spelman, vice-présidente marketing en charge de l'activité Xeon et datacenter chez Intel, lors d'un point presse le mardi 16 juin 2020. Rien de vraiment nouveau en fait par rapport aux générations précédentes, mais des performances multipliées par 1,9 par rapport par rapport à une plate-forme 4 voies équivalente de cinq ans.

Toujours gravées en 14 nm, les puces Xeon Cooper Lake-SP travaillent avec un jeu de composants Intel C620A - avec un socket LGA 4189 (socket P +) - via DMI avec jusqu'à 20 voies PCIe Gen 3, 10 ports USB 3.0 et 14 ports SATA. Toujours pas de PCI Gen4 alors qu'AMD le généralise sur ses processeurs. Le chipset supporte des systèmes 4 et 8 voies interconnectées via l'Ultra Path Interconnect maison. Des instructions complémentaires Bloat16 ont été ajoutées pour accélérer les traitements AI et les fonctionnalités Intel SST (Speed Select Technology) permettent aux administrateurs systèmes de mieux contrôler l'optimisation des performances du processeur en fonction des charges de travail.

Quelles fréquences et combien de coeurs ?

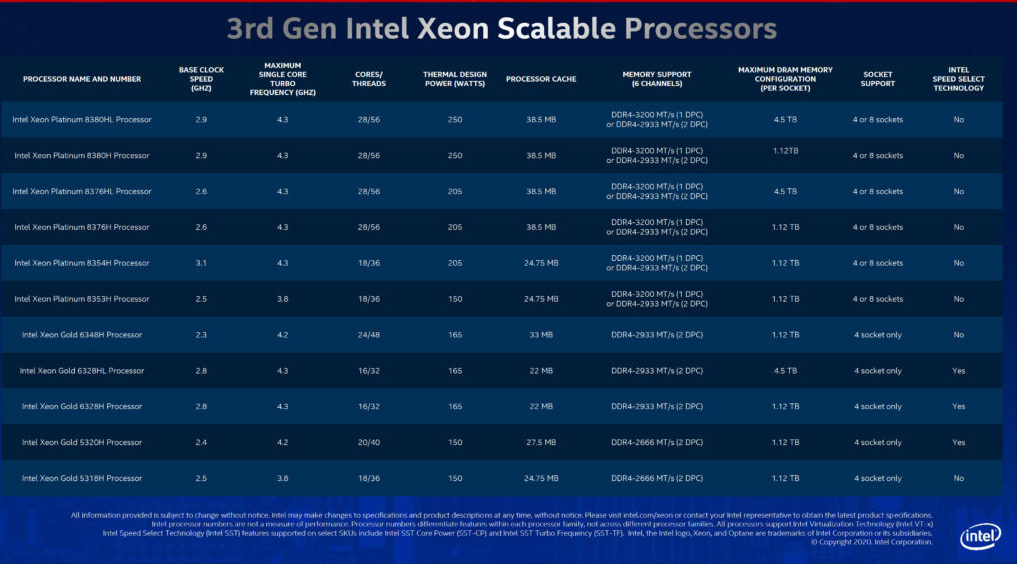

Mais un processeur, ce sont aussi des fréquences et des coeurs, et Intel rechigne depuis plusieurs mois à mettre en avant ces caractéristiques au profit des usages. Mais la performance des puces repose avant tout sur ces points, et AMD ne se prive pas de communiquer sur le nombre de coeurs et la fréquence de ses puces pour serveurs Epyc. Les processeurs Xeon Platinum 8300 prennent en charge les configurations 4S et 8S. Le modèle phare est le Xeon Platinum 8380HL qui comprend 28 coeurs (56 threads) et 38,50 Mo de cache au total. La fréquence de base démarre à 2,9 GHz et monte à 4,3 GHz en mode turbo avec une consommation de 250 Watts. Il existe deux variantes de cette puce: HL et H. La première supporte jusqu'à 4,5 To de RAM (DDR4) tandis que la seconde se limite à 1,12 To. Les Xeon Platinum 8376HL et 8376H conservent la même configuration de base, mais avec des fréquences de base plus basses (2,6 GHz), ce qui se traduit par un TDP inférieur (205 Watts).

Les puces quatre voies sont les séries Xeon Gold 6300 et Xeon Gold 5300. Le Xeon 6348H accueille 24 coeurs avec une horloge de base de 2,3 GHz (4,2 GHz en turbo) un 33 Mo de cache. Le tout avec un TDP de 165 Watts. Le Xeon Gold 6328HL dispose de 16 coeurs avec des fréquences de 2,8 GHz et 4,3 GHz en turbo pour un TDP de 165 Watts. Ce dernier est le seul processeur de la gamme Xeon Gold à prendre en charge des capacités de RAM de 4,5 To.

Certaines de ces puces prennent en charge le mode SST d'Intel, il s'agit des Xeon Gold 6328HL, Xeon Gold 6328H et lXeon Gold 5320H. La technologie SST est livrée avec deux modes, SST-CP (Core Power) et SST-TF (Turbo Frequency). Selon les besoins, SST vous permet d'ajuster la fréquence de base, essentiellement en augmentant la puissance pour les charges de travail essentielles, aux moments les plus critiques. Vous avez le détail des puces lancées par Intel dans le tableau ci-dessous. Signalons pour conclure cette partie que la prochaine génération de Xeon Scalable reposera sur l'architecture Sapphire Rapids et accueillera le jeu d'instructions AMX.

La famille Intel Xeon Cooper Lake-SP. (Crédit : Intel)

Des mémoires persistantes plus rapides

En complément, le fondeur de Santa Clara commercialise des mémoires persistantes Optane série 200 (Barlow Pass seconde génération), avec jusqu'à 4,5 To par socket pour accompagner les charges de travail intensives, telles que les bases de données en mémoire, la virtualisation, l'analytique et le HPC. Comme la première génération, la série Optane 200 DCPMM est disponible en modules de 128 , 256 et 512 Go et fonctionnera à la même vitesse de mémoire DDR4-2666. Intel affirme que cette nouvelle génération d'Optane offre une bande passante mémoire 25% plus élevée que la génération précédente. Signalons encore que les puces Copper Lake Xeon Platinum prennent en charge la DDR4-3200, mais uniquement dans un scénario 1 DIMM par canal (1 DPC). Le double canal (2 DPC) est pris en charge avec des barrettes DDR4-2933. La prise en charge de la DDR4-3200 donne au système une augmentation de 9,1% de la bande passante : 25,60 Go/s par canal contre 23,46 Go / s précédemment.

Après le stockage, Intel entend imposer ses composants Optane comme une alternative à la DRAM pour les solutions in-memory. Si ces dernières sont un peu plus performantes que la NAND flash, elles restent encore en deçà de la DDR4. (Crédit : Intel)

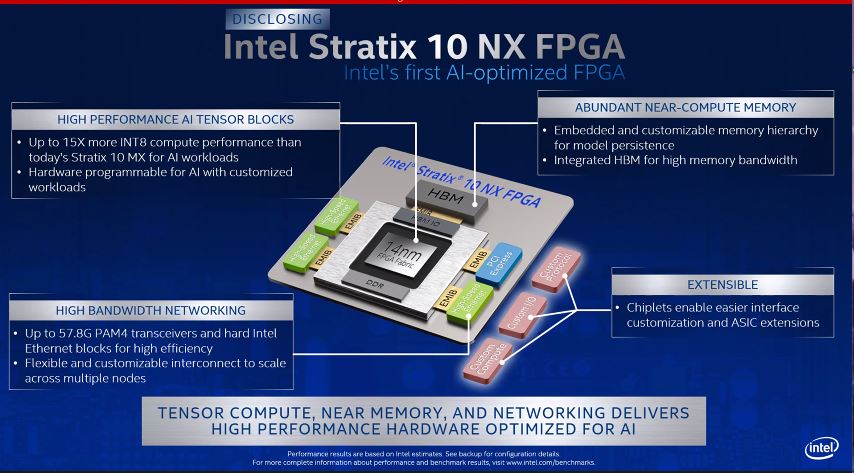

Terminons avec le FPGA Stratix 10 NX, qui est le premier circuit programmable d'Intel destiné à booster les traitements IA. L'accélération FPGA de ce circuit peut être ajustée, reconfigurée et mise à l'échelle pour les applications qui nécessitent des calculs tels que le traitement du langage et la détection des fraudes. Intel Stratix 10 NX FPGA comprend une bande passante élevée, une mémoire intégrée (HBM), des capacités réseau hautes performances et un bloc arithmétique optimisé pour l'IA appelée AI Tensor Blocks. Ce dernier contient un tableau de multiplicateurs de moindre précision normalement utilisé pour les modèles d'IA arithmétiques. Comme les accélérateurs GPU, les FPGA viennent toujours en complément des puces x86, toujours nécessaire pour démarrer les systèmes, mais avec des applications optimisées, ces circuits dédiés ont aujourd'hui le vent en poupe dans les systèmes HPC et les ressources cloud distribuées. David Moore, en charge des activités FPGA chez Intel, nous a ainsi expliqué que le fondeur travaille avec Microsoft pour mieux exploiter les FPGA sur Azure.

Intel travaille avec Microsoft afin de mieux exploiter ses circuits FPGA Sratix. (Crédit Intel)

Suivez-nous