Antonio Neri, CEO de HPE a inauguré Discover à Barcelone en insistant sur la vitesse d'adoption de l'IA. (Crédit : JC)

Lors de la déclinaison européenne de son évènement Discover, HPE a concentré son discours et ses annonces autour de l'IA. Le fournisseur crée une architecture dédiée à cette technologie comprenant des évolutions de l'offre Greenlake sur le stockage ou sur les capacités de développer et tester des modèles d'IA. Le partenariat avec Nvidia est aussi renforcé.

« Discover is AI », a lancé Antonio Neri, CEO de HPE en introduction de l'évènement européen du fournisseur qui se déroule à Barcelone. Il observe que « l'adoption de l'IA et de l'IA générative se fait à une vitesse jamais vue auparavant ». Mais il rappelle que « les workloads IA ont besoin de ressources, de capacités de calcul intensif, d'un stockage fichier optimisé et des logiciels dédiés ainsi que d'un accompagnement sur l'intégration ». Une couche que HPE enrobe sous le vocable « AI native architecture ».

Une architecture à plusieurs niveaux

Plusieurs services sont proposés au sein de cette stratégie notamment au sein de Greenlake (l'offre IT as a service de l'entreprise). HPE a ainsi actualisé son offre Machine Learning Development Environment, un studio pour l'entraînement des modèles. Il intègre des fonctionnalités complémentaires comme le fine tuning (optimisation des modèles) et la possibilité de créer des prototypes et des tests. Elle vient compléter le service Greenlake for LLM présenté en juin dernier lors de Discover aux Etats-Unis. Sur la partie logicielle, l'environnement analytique Ezmerald bénéficie lui aussi d'une mise à jour fonctionnelle en optimisant les datalakes à l'usage des accélérateurs GPU et CPU. Ezmeral prend désormais en charge davantage d'outils tiers, tels que Whylogs pour la surveillance des modèles et Voltron Data pour des requêtes de données plus rapides, accélérées par GPU.

Sur la partie stockage, HPE étend l'offre Greenlake for File Storage aux traitements IA. « Nos clients nous ont demandé de travailler sur des environnements accueillant plus de volume de données non structurées, avoir une plus grande densité et améliorer les performances », nous a indiqué Patrick Osborne, responsable cloud data infrastructure au sein de la division stockage de HPE. Pour mémoire, HPE avait présenté en à l'été dernier Greenlake for File Storage, qui reposait sur l'intégration de la solution de Vast Data. Aujourd'hui, l'effort est porté sur des baies full flash Alletra MP. La densité a été renforcée en supportant des lecteurs NVMe de 30 To et une capacité pouvant aller de 88 à 250 Po. Côté performance, HPE annonce le support du switch Quantum-2 Infiniband de Nvidia optimisé pour les calculs GPU. Greenlake for File Storage for AI sera disponible en 2024.

Une extension du partenariat avec Nvidia

Comme la concurrence, HPE ne peut pas prétendre être un acteur important dans l'IA sans s'associer avec Nvidia. Mais la firme, basée maintenant à Houston, dispose d'un atout par rapport à ses compétiteurs, l'expertise dans le HPC. « L'IA a besoin de calcul intensif et HPE a une position idéale en la matière », rappelle Antonio Neri. Il en profite pour préciser que cette activité est en croissance annuelle de près de 40 % par rapport à celles des serveurs en fort recul sur le Q4 2023.

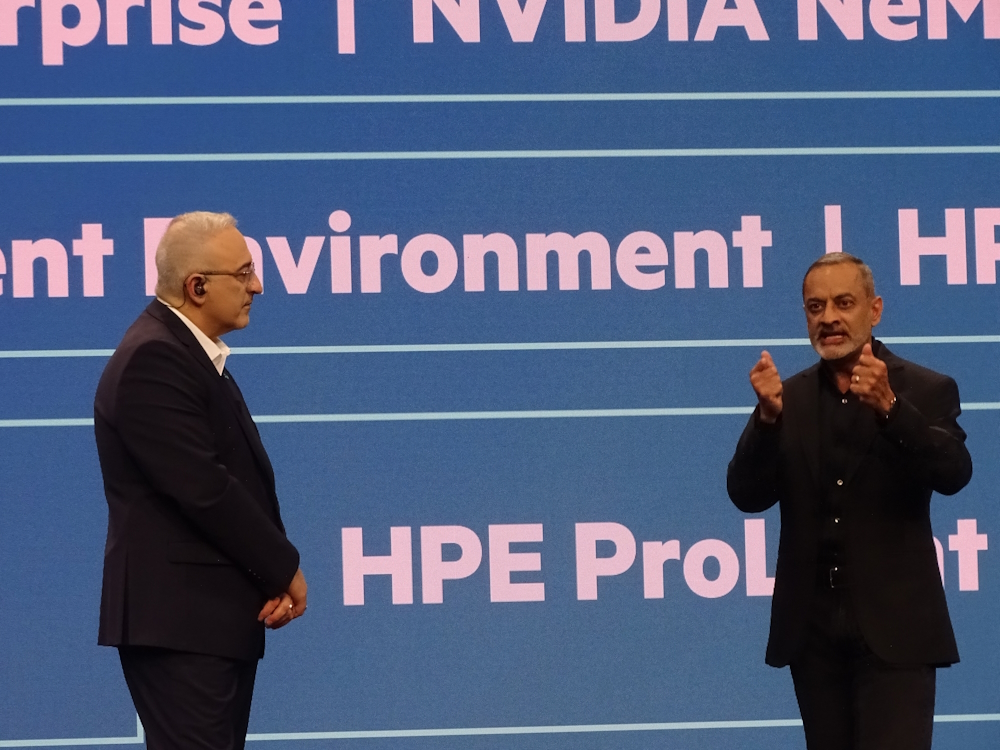

Antonio Neri, CEO de HPE et Manuvir Das, vice-président de l'activité entreprise de Nvidia ont présenté l'extension du partenariat entre les deux sociétés autour de l'IA. (Crédit : JC)

En compagnie de Manuvir Das, vice-président de l'activité entreprise de Nvidia, il a présenté différentes briques à destination des sociétés pour l'entraînement, l'inférence et le déploiement des applications IA. Basée sur le serveur ProLiant DL380a, la plateforme est préconfigurée avec des accélérateurs GPU L40S, des DPU BlueField-3 et Spectrum-X (SmartNic Ethernet pour la partie réseau). Dans un premier temps, elle est dimensionnée avec 16 serveurs et 64 accélérateurs GPU pour accueillir le LLM de Meta, Llama 2 doté de 70 milliards d'hyperparamètres. Sur la brique logicielle, Nvidia propose son framework Nemo pour entraîner et déployer des IA génératives. Pour autant, HPE regarde d'autres framerwork comme celui proposé par Alep Alpha (où HPE a participé à la levée de fonds en novembre dernier). Une chose est sûre, avec cette offre pré-packagée et l'architecture AI native, Antonio Neri entend bien proposer aux entreprises « une IA factory pour déployer des applications IA à la demande ».

Le channel va gagner en maturité sur l'IA

Cette architecture et ses différentes offres vont être mises à disposition du channel pour répondre aux questions de leurs clients. « Nous allons réaliser des workshops pour les partenaires sur les cas d'usage sur l'IA. Il faut les faire progresser en maturité », nous explique Paul d'Alena, responsable channel chez HPE France. Un travail qui s'inscrit dans le programme Ready Vantage révisé et officiellement lancé depuis le 1er novembre et qui vise à « mettre en avant l'expertise de nos partenaires ».

Concernant les prévisions pour 2024, Paul d'Alena est convaincu que « la croissance va être portée par l'IA » et que le marché va être plus sélectif « les serveurs plus spécialisés, un besoin de stockage optimisé avec Alletra MP et les services data ». Et la maturité va gagner la totalité des entreprises. « L'IA n'est pas réservée qu'aux grands comptes, nous avons plusieurs partenaires qui adressent des très petites entreprises et ils veulent pouvoir proposer des solutions accessibles pour ce public, sans se préoccuper de la couche infrastructure », glisse le responsable.

Suivez-nous