Lors de son événement annuel, David Flynn, le CEO de Hammerspace, nous a exposé son concept de Tier 0 pour mieux exploiter le stockage flash des serveurs avec GPU. (Crédit S.L.)

Alors que les entreprises accélèrent leurs investissements dans l'intelligence artificielle, Hammerspace vient positionner sa solution de stockage distribué afin de mieux gérer les ressources flash disponibles dans les fermes de serveurs dopés aux GPU.

Les projets autour de l'IA connaissent des développements fulgurants, et avec eux, une explosion des besoins en infrastructures performantes et flexibles. Selon une étude récente présentée par Hammerspace, les dépenses liées aux serveurs GPU ont doublé ces trois dernières années, mais une part importante de leurs capacités de stockage reste sous-utilisée. C'est dans ce contexte que la société avance ses pions avec sa solution capable d'exploiter pleinement les ressources flash existantes, tout en répondant aux défis posés par les environnements distribués et les applications d'IA massivement parallèles.

Mieux gérer le stockage disponible

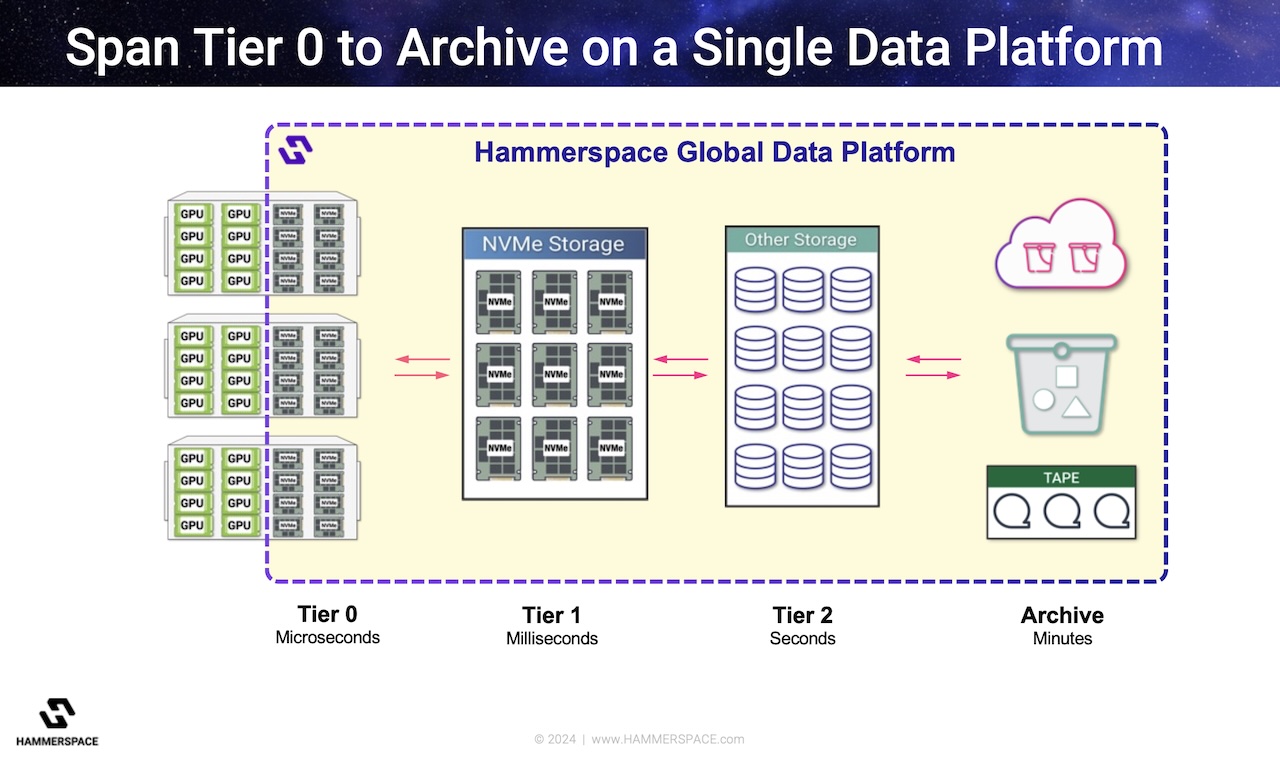

À l'origine de Hammerspace, on trouve une ambition singulière : abolir les frontières entre les données et les ressources de calcul. David Flynn, fondateur et CEO de l'entreprise, a souligné dans sa présentation lors d'un IT Press Tour fin janvier dans la Silicon Valley l'importance de rapprocher les données des machines qui les utilisent, afin d'exploiter pleinement les capacités des infrastructures modernes. Cette approche se traduit notamment par l'introduction du "Tier 0", un niveau de stockage ultra-rapide directement intégré au sein des serveurs GPU.

Avec son concept de Tier 0, Hammerspace redéfinit la gestion des données à l'ère de l'intelligence artificielle.

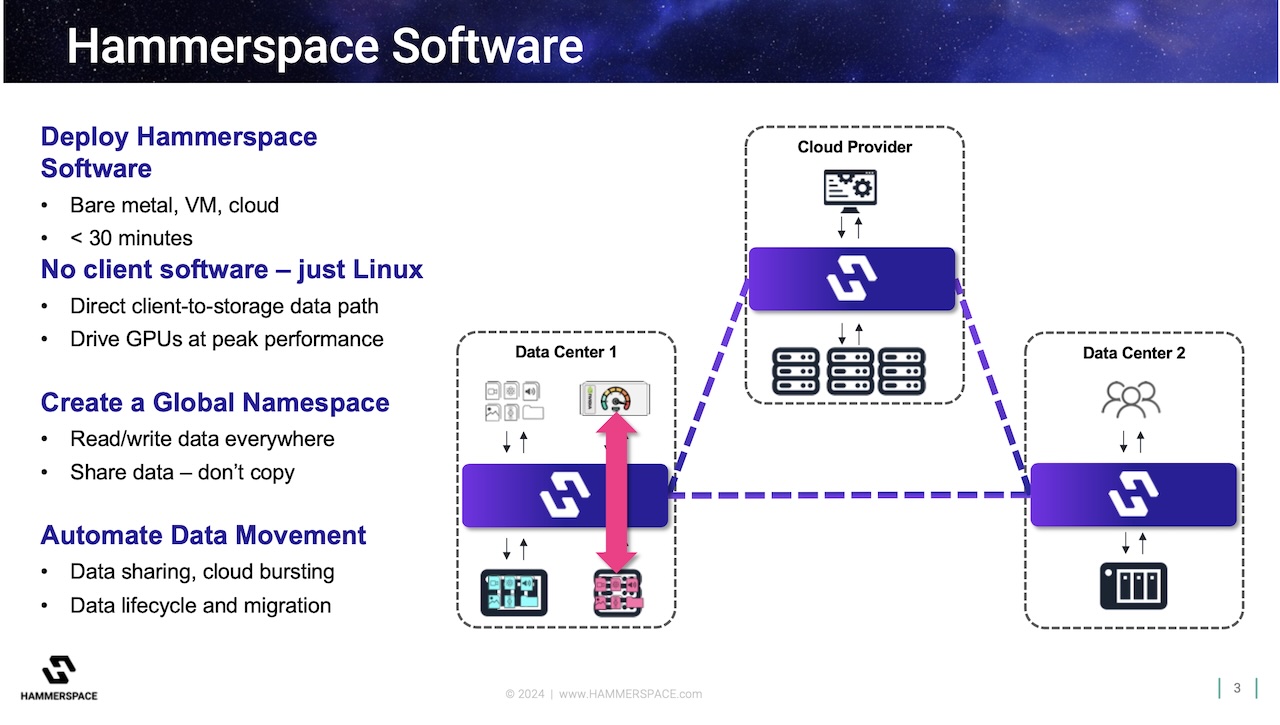

La clé de voûte de cette approche réside dans l'exploitation du noyau Linux. David Flynn explique que l'intégration du "local IO patch" permet au système d'opérer de manière efficiente : « Le noyau Linux peut désormais reconnaître que le serveur agit simultanément comme client et fournisseur de stockage, ce qui court-circuite les protocoles réseau traditionnels pour accéder directement aux données avec la vitesse du stockage NVMe local ». Cela supprime les goulots d'étranglement associés aux transferts via le réseau, en offrant une communication directe entre les données et les applications. Résultat : une accélération considérable des opérations critiques, comme les sauvegardes et les reprises après incident. Cette architecture est particulièrement adaptée aux environnements massivement parallèles, où des milliers de GPU (huit par serveur) collaborent pour entraîner des modèles d'intelligence artificielle complexes. Elle offre une flexibilité sans précédent, grâce à une gestion des données entièrement orchestrée. Contrairement aux systèmes de stockage traditionnels, qui imposent des règles fixes de gestion, Hammerspace adopte un modèle déclaratif. Les administrateurs définissent simplement les exigences de performance ou de fiabilité, et le système ajuste automatiquement la localisation et la duplication des données pour répondre à ces objectifs.

En s'appuyant sur le protocole NFS parallèle (pNFS), la solution propose également de répartir les données sur plusieurs noeuds de manière transparente. David Flynn décrit cette capacité comme un véritable « pont » entre les différents tiers de stockage. Les fichiers peuvent être déplacés librement d'un serveur à un autre, ou d'un niveau ultra-rapide à une archive de longue durée, sans interrompre les applications qui y accèdent. Cette flexibilité est rendue possible par une abstraction des métadonnées, qui garantit que la localisation physique des fichiers reste invisible pour les utilisateurs.

Une gestion optimisée des ressources

Outre ses performances techniques, Hammerspace se distingue par son approche innovante de la gestion des ressources. Les données, autrefois cloisonnées dans des silos, deviennent accessibles à l'ensemble des noeuds d'un réseau grâce à une vision unifiée. Le CEO illustre cette révolution en évoquant la gestion des points de contrôle (checkpoints) dans les systèmes d'entraînement IA. « Dans un environnement traditionnel, chaque point de contrôle impose un arrêt complet du cluster pour sauvegarder l'état des GPU, ce qui peut représenter jusqu'à 10 % du temps total d'utilisation. Avec Hammerspace, ces données sont stockées localement à une vitesse décuplée, puis orchestrées vers des noeuds distants pour garantir leur durabilité ». Ce modèle optimise également la consommation énergétique. Les GPU, gourmands en énergie, ne sont plus contraints de rester inactifs en attendant que les sauvegardes soient effectuées. Par ailleurs, la solution réduit les besoins en infrastructures de stockage externes, ce qui diminue non seulement les coûts matériels, mais aussi la consommation électrique globale.

Avec son architecture à la fois globale et distribuée, Hammersapce répond aux défis des infrastructures modernes tout en anticipant les besoins futurs.

David Flynn met également en avant la capacité de Hammerspace à intégrer les infrastructures existantes sans nécessiter de modifications complexes. Contrairement à d'autres solutions, qui imposent l'installation de logiciels dédiés ou de pilotes spécifiques, Hammerspace s'appuie uniquement sur les outils natifs de Linux. « Notre objectif est de simplifier la gestion des données. En utilisant des fonctionnalités standard, nous évitons aux entreprises de devoir investir dans des solutions coûteuses et complexes », affirme le CEO.

Une IPO en perspective

Hammerspace ne se contente pas d'innover sur le plan technique. L'entreprise s'appuie également sur des partenariats stratégiques pour accélérer son adoption à l'échelle mondiale : si près de 60% des revenus sont réalisés aux Etats-Unis, l'Europe compte pour 40%. La récente alliance avec Hitachi Vantara vient renforcer le développement commercial. En combinant le logiciel de gestion des données de Hammerspace avec les infrastructures matérielles d'Hitachi, les deux entreprises proposent une solution clé en main pour les environnements IA. Ce partenariat vise notamment les grandes entreprises, qui bénéficient désormais d'une plateforme simplifiée pour gérer leurs charges de travail complexes tout en réduisant les coûts opérationnels.

Avec une croissance de x10 de son chiffre d'affaires en 2024 et une augmentation rapide du nombre de salariés (+75% ce qui donne aujourd'hui près de 200 personnes), l'entreprise semble prête à franchir l'étape de l'introduction en bourse d'ici deux à trois ans. David Flynn reste toutefois mesuré, soulignant que « le véritable défi réside dans la capacité à maintenir cette dynamique tout en conservant notre avantage technologique ».

Suivez-nous