CEO et fondateur de Groq, Jonathan Ross mise sur sa plateforme LPU pour aider les entreprises à accélérer leurs traitements LLM. (Crédit S.L.)

Encore inconnu il y a un an, Groq est bien décidé à surfer sur la vague IA (générative ou autre) avec sa plateforme de calcul LPU taillée pour l'inférence et l'accélération des traitements LLM.

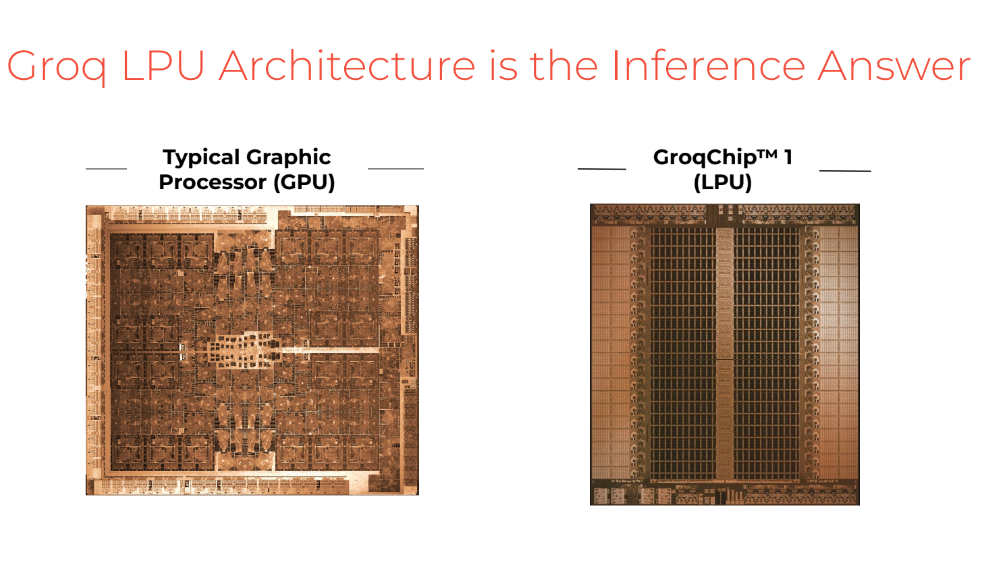

Si des fournisseurs comme Amazon, Google, Microsoft, Nvidia ou encore SambaNova développent leurs propres ASIC IA, on assiste à une accélération suivie d'une spécialisation autour des coeurs tensors depuis plusieurs années pour répondre aux besoins des applications IA exploitant les algorithmes de formation et d'inférence. Et ce dans différents secteurs comme les systèmes informatiques et embarqués, tels que les voitures autonomes, la vision industrielle, la PNL, la robotique, l'Internet des objets et autres tâches gourmandes en données ou pilotées par des capteurs. Ancien de Google ayant travaillé sur le premier TPU (Tensor Processing Unit) de la firme lancé en 2015, Jonathan Ross a fondé en 2016 sa propre entreprise pour développer des accélérateurs taillés pour l'inférence IA. Baptisées GroqChip, ces puces de type LPU (Language Processing Unit) viennent concurrencer les très demandés GPU de Nvidia sur le marché de l'intelligence artificielle. Gravées en 14 nm chez GlobalFoundries, les GroqChip reposent sur un design plus simple que les circuits Nvidia (des cartes graphiques à l'origine). Les performances ne sont toutefois pas comparables, Nvidia montant jusqu'à 1 000 Tflops avec son accélérateur H100 (30 000 $HT), alors que le GroqChip plafonne à 188 Tflops.

Gravé en 14 nm chez GlobalFoundries, le TPU de Groq est un accélérateur dédié aux calculs IA comme PyTorch, TensorFlow et ONNX. (Crédit Groq)

" Il y a environ un an, personne ne se souciait de Groq, personne ne connaissait la start-up. Que s'est-il passé depuis ? ", nous a apostrophé Jonathan Ross. "En 2022, l'une des quatre entreprises qui formaient de grands modèles de langage a décidé de simplement publier cette chose sur Internet en tant que chatbot et elle existe depuis plus d'un an ". Avant, il fallait utiliser une API et un programme pour y accéder. Et, tout d'un coup, l'IA générative est devenue accessible au plus grand nombre dans un simple navigateur. " Il y a environ 10 ans, chez Google, nous avons lancé un projet, désormais connu sous le nom de TPU [des ASIC conçus pour accélérer la vitesse de traitement des systèmes d'apprentissage machine] , à l'origine de cette rupture technologique, qui a fini par être diffusée dans l'industrie ", nous a indiqué le CEO de Groq Jonathan Ross. Par rapport à un accélérateur GPU, les TPU sont conçus pour un volume élevé de calculs de faible précision (par exemple, une précision aussi faible que 8 bits) avec plus d'opérations d'entrée/sortie par joule. "Si vous avez entendu parler des coeurs tensors des GPU NVIDIA, ils ont en fait été défrichés par Google. Et cela provient de la première puce TPU que j'ai conçue ". Rappelons que Nvidia a introduit ses premières unités Tensor en mai 2017 avec la microarchitecture GPU Volta utilisée par les produits Tesla V100.

A la différence des accélérateurs GPU, les LPU, comme les TPU, ont été conçus dès l'origine pour les calculs IA. (Crédit S.L.)

Google à l'origine de la vague tensor

Un tensor, un tenseur en français, est un objet mathématique, dont la valeur s'exprime dans un espace 3D. En 2015 avec son premier TPU, Google a créé son propre cadre d'apprentissage automatique qui utilise des tensors, car ceux-ci permettent d'exploiter des réseaux de neurones hautement évolutifs. Google a surpris les acteurs du marché en rendant open source ses librairies d'apprentissage automatique Tensorflow en novembre 2012 (publié sous licence Apache), mais cela a peut-être été un coup de génie car Tensorflow est rapidement devenu l'un des frameworks d'apprentissage automatique les plus populaires utilisés par les développeurs. Pendant ce temps, les fournisseurs de puces semblent optimiser leurs produits, soit pour Tensorflow directement, soit pour les calculs tensoriels (comme le fait Nvidia avec le V100). En d'autres termes, les fournisseurs de GPU comme Nvidia ou AMD se battent pour améliorer le cadre d'apprentissage automatique open source de Google - une situation qui ne peut que profiter à ce dernier.

Exploitant l'interface PCI Gen4, la carte Groq simplifie le déploiement de la plateforme du fournisseur. (Crédit Groq)

"Maintenant, pourquoi sommes-nous ici aujourd'hui ? Parce que 2023 a été l'année où l'IA est devenue possible. Il y avait du potentiel, mais il y avait encore une certaine confusion quant à savoir si cela allait ou non prendre dans les entreprises. 2024 sera l'année où l'IA deviendra réalité", a poursuivi le CEO de Groq. "Le moteur d'inférence LPU (Language Processing Unit), est un système de traitement inventé par Groq pour gérer des applications à forte intensité de calcul avec un composant séquentiel comme celui des grands modèles de langage (LLM). Le moteur d'inférence LPU est conçu pour surmonter les deux goulots d'étranglement des LLM, la quantité de calcul et la bande passante mémoire", explique Groq. Circuit dédié, un LPU a moins de ressources de calcul qu'un GPU, mais plus qu'un processeur central (CPU), et réduit le temps calculé par mot, permettant ainsi de générer des séquences de texte beaucoup plus rapidement. Pour aider les développeurs à exploiter sa plateforme TPU (puce, carte PCI et serveur), Groq met en avant son SDK baptisé Groqware, qui rassemble un compilateur, une API et des outils pour aider à porter des charges de travail HPC et ML. Groq Compiler, co-développé avec l'architecture TSP, vient faciliter le déploiement de modèles d'apprentissage profond (PyTorch, TensorFlow et ONNX). L'API Groq offre aux clients un contrôle granulaire de GroqChip. Enfin, des outils tels que le profileur et le runtime GroqView viennent améliorer et simplifier les flux de travail des développeurs. Précisons que Groq commercialise une puce (GroqChip), une carte PCI Gen4 (GroqCard Accelerator) et surtout un serveur 4U (GroqNode Server) reposant sur deux processeurs AMD Epyc 7313 épaulés par 1 To de Dram et associés à 8 GroqCard pour monter à 1,5 Pflops. Un concurrent déclaré du serveur DGX de Nvidia.

Un petit mot pour finir sur la signification du nom Groq : il provient du mot grok qui a été utilisé pour la première fois en 1961 dans l'ouvrage de SF " En terre étrangère " de Robert Heinlein. Dans ce roman, grok signifie comprendre quelque chose de manière intuitive ou par empathie.

Suivez-nous