« OpenShift Virtualization Enterprise permet d'exécuter des machines virtuelles parallèlement à des conteneurs depuis la même plate-forme », indique Mos Amokhtari, directeur solution architecture chez Red Hat. (Crédit Red Hat)

Oui, il est possible de déployer des conteneurs et Kubernetes directement sur des serveurs physiques (en mode bare metal) même si la gestion d'un cluster de conteneurs reste plus complexe et que sa sécurité de base, à en croire certains de nos interlocuteurs dans le dossier, n'est pas d'un niveau aussi élevé. Pour Mos Amokhtari, directeur solution architecture chez Red Hat, ce n'est plus un problème de sécurité, la conteneurisation progresse et trouve surtout sa place dans des nouveaux projets. Un dernier point que partage Stéphane Berthaud, directeur technique de Nutanix, qui cite l'exemple de l'entreprise ANSC (Agence nationale de sécurité civile), créée en 2018, en charge du projet NexSIS 18-112, le système d'information unifié des sapeurs-pompiers sur l'ensemble du territoire national. En clair, l'ANSC propose un système mutualisé et centralisé capable de dialoguer avec les systèmes existants déployés dans chaque département et faciliter l'interconnexion avec l'ensemble de l'écosystème IT de la sécurité civile. Et pour cela, l'ANSC a opté dès le départ pour la plate-forme Nutanix Cloud Infrastructure afin de déployer des clusters Kubernetes en IAS (Infrastructure As Code) avec une chaîne de livraison continue (CI/CD).

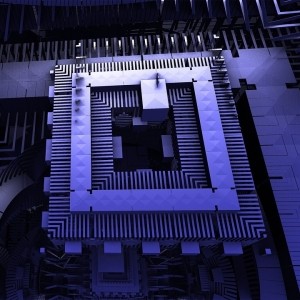

Hors nouveaux projets, c'est plus complexe comme le rappelle Mos Amokhtari : « Aujourd'hui, la conteneurisation sur du bare metal est surtout un chantier de refactoring qui reste coûteux pour du legacy. C'est un travail long même si Red Hat fournit aussi des outils et templates pour faciliter la migration. De nombreuses applications d'entreprise existantes s'exécutent sur des machines virtuelles (VM) et continueront de le faire pendant longtemps. » Pour ces raisons, virtualisation et conteneurisation sont surtout qualifiées de complémentaires. Red Hat propose d'ailleurs OpenShift Virtualization Enterprise (aussi connu sous KubeVirt en version communautaire) - toujours en cours de développement - qui promet d'exécuter des machines virtuelles parallèlement à des conteneurs depuis la même plate-forme, avec à la clé, une simplification de la gestion et une réduction des délais de production. Les entreprises peuvent ainsi tirer parti des investissements déjà réalisés en matière de virtualisation et profiter de la simplicité et de la rapidité qu'offre cette plate-forme d'applications moderne. Techniquement, OpenShift Virtualization exploitent des pods lesquels fonctionnent sur du KVM.

Aurélien Violet, en charge des produits et du marketing chez Enix, défend aussi cette complémentarité : « La virtualisation de serveur apporte de l'isolation et donc de la sécurité, elle facilite également la gestion de l'infrastructure par rapport à du serveur bare metal (migration de VM à chaud, résilience aux pannes hardware, meilleure utilisation des CPU modernes aux très nombreux core, simplification des backups et snapshots...). De son côté, la conteneurisation apporte une couche d'abstraction supplémentaire, elle permet la mutualisation des ressources entre les applications sur un seul et même OS tout en simplifiant et accélérant leur intégration et leur déploiement. L'orchestration des conteneurs avec Kubernetes apporte par ailleurs de la portabilité, de la résilience et elle facilite la maintenance et l'opération des plates-formes. Pour combiner ces avantages, sur la plupart des plates-formes de nos clients, nous avons d'ailleurs déployé et opéré des clusters Kubernetes qui tournent sur notre solution Proxmox Private Cloud. » Même avis sur la complémentarité pour Marc-André Pezin, directeur marketing, communication et sales chez Vates. A ce titre, l'éditeur est en train de mettre au point le projet Pyrgos construit sur Xen Orchestra et qui permet de déployer facilement des clusters Kubernetes prêts pour la production au-dessus de leur infrastructure XCP-ng/Xen Orchestra. En attendant, Vates propose deux méthodes possibles au-dessus de sa plate-forme de virtualisation pour déployer des clusters Kubernetes : l'utilisation du provider Packer/Terraform, une approche Infra as code permettant aux utilisateurs de faire leur propre recette, ou se connecter à un provider type Rancher pour pouvoir créer son cluster sur XCP-ng directement depuis un provider.

Suivez-nous