Contrôler les informations sensibles auxquels les utilisateurs peuvent avoir accès depuis Copilot dans Microsoft 365 constitue un enjeu de gouvernance et de sécurité clé. (crédit : D.F.)

L'assistant GenAI Microsoft 365 Copilot peut faire apparaître des informations sensibles dans des fichiers dont l'accès est autorisé de manière excessive. Des fonctions ont été ajoutées à SharePoint et à Purview pour mieux contrôler les habilitations.

Alors que Microsoft pousse les entreprises à adopter son assistant GenAI Copilot dans Microsoft 365, de nombreux clients se sont heurtés à un souci majeur : la capacité de cet outil à remonter des informations confidentielles aux employés. Pour résoudre ce problème de partage excessif, le fournisseur a présenté de nouvelles fonctions lors de son dernier événement développeurs Ignite, notamment dans SharePoint Advanced Management et Purview, ainsi qu'un guide de déploiement de son assistant M365 Copilot. « Les outils d'IA tels que Copilot sont une préoccupation croissante pour les professionnels de la sécurité des données en raison de la quantité et de la nature des données auxquelles ces outils ont accès », explique Jennifer Glenn, directrice de recherche de l'activité sécurité et confiance d'IDC. « Microsoft 365 étant omniprésent dans l'entreprise, j'ai souvent entendu parler des inquiétudes concernant l'accès inapproprié à des données ou leur partage par Copilot. » Et d'ajouter que les nouveaux outils de gouvernance et de sécurité des données de l'éditeur pour traiter le partage excessif sont « essentiels pour que les entreprises se sentent confiantes dans l'adoption d'outils d'IA tels que Copilot. »

L'un des points forts de M365 Copilot est sa capacité à passer au crible de larges pans de données d'entreprise et à récupérer des informations à l'intention d'un utilisateur. Les réponses sont basées sur les informations contenues dans l'environnement M365 d'une entreprise, telles que les documents Word, les courriels, les messages Teams, etc. Revers de la médaille ? Les modèles de langage de Copilot peuvent également accéder à des fichiers sensibles qui ne sont pas verrouillés. Pour certaines entreprises, cela s'est traduit par l'accès à des données confidentielles par les salariés dans les réponses de Copilot : salariales, juridiques, voire des documents stratégiques - top secrets - de l'entreprise, ou toute autre information à laquelle Copilot a pu accéder. « L'IA est très douée pour trouver des informations, et elle peut faire remonter plus d'informations que prévu », a déclaré Alex Pozin, directeur du marketing produit chez Microsoft, lors d'une session sur Ignite. « C'est pourquoi il est très important de s'attaquer au partage excessif. L'implication pour les entreprises est qu'« il peut être difficile de commencer avec l'IA, parce qu'il faut résoudre ces problèmes avant d'y être confrontés », a-t-il déclaré. « Généralement, ces problèmes sont des effets collatéraux de la collaboration », a déclaré M. Pozin, en particulier en ce qui concerne les sites SharePoint et OneDrive.

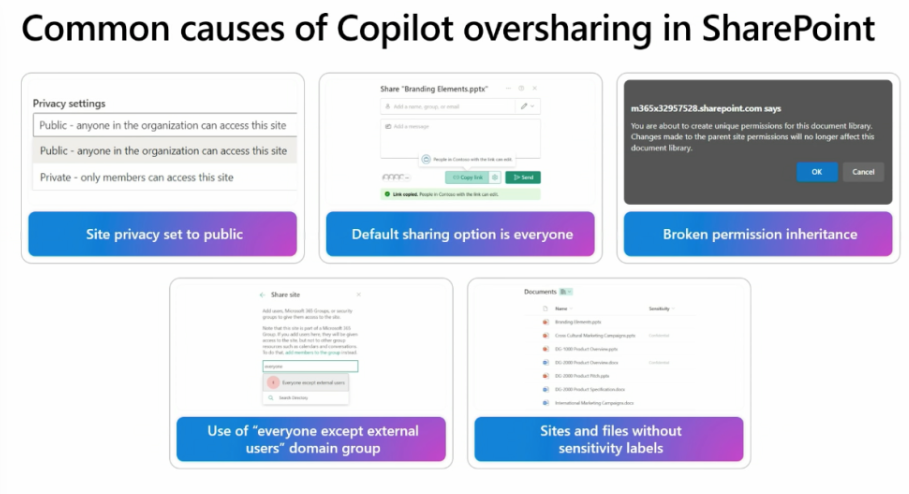

Il y a plusieurs raisons pour lesquelles M365 Copilot de Microsoft peut « surpartager » des données. crédit : Microsoft

L'accès aux fichiers Sharepoint mieux contrôlé

Les raisons pour lesquelles Copilot peut partager trop de données sont, entre autres, la confidentialité du site paramétrée sur « public » plutôt que sur « privé », une option de partage de fichiers par défaut qui favorise l'accès aux données par tous les membres d'une société, et l'absence de marqueurs de niveaux de sensibilité. Mais ce n'est pas une mince affaire : les sites de certaines entreprises contiennent des « millions » de fichiers, a déclaré M. Pozin. Une partie du plan du fournisseur consiste à élargir l'accès à SharePoint Advanced Management (SAM). SAM - introduit dans le cadre de SharePoint Premium l'année dernière - sans frais supplémentaires dans les abonnements à M365 Copilot à partir de début 2025. Rappelons que M365 Copilot coûte 22€ HT par utilisateur et par mois et SharePoint Premium 3$ HT par utilisateur et par mois).

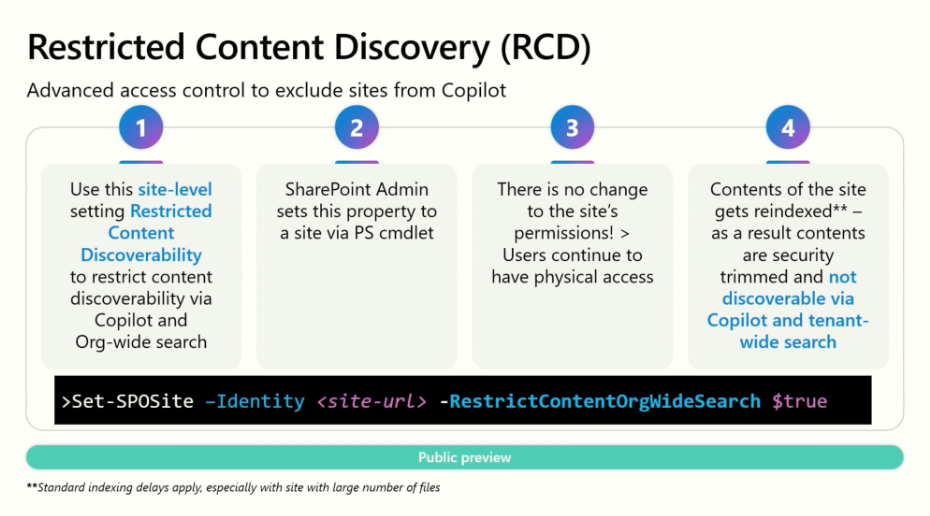

Il existe également de nouvelles fonctionnalités pour SAM qui, selon Microsoft, entraineront un meilleur contrôle de l'accès aux fichiers SharePoint. Par exemple, les rapports sur l'état des autorisations (maintenant en disponibilité générale) identifient les sites SharePoint « surpartagés », tandis que les examens de l'accès aux sites (également en GA) demandent aux propriétaires de sites de modifier les autorisations. La découverte restreinte de contenu, lancée ce mois-ci, offre aux administrateurs d'empêcher Copilot d'effectuer des recherches sur un site et de traiter le contenu ; sinon, le site restera inchangé et les utilisateurs pourront y accéder comme d'habitude. Cette fonction s'appuie sur le contrôle d'accès restreint, lancé en 2023, qui accorde aux administrateurs de restreindre l'accès au site aux seuls propriétaires du site, tout en empêchant Copilot de résumer les fichiers en même temps (une mesure temporaire, selon Microsoft). « Il existe des situations où vous identifiez des sites très secrets ou des sites révélant une sauce secrète que vous voulez cacher de Copilot et ne jamais risquer que quelqu'un puisse voir ce contenu sans le vouloir », a fait savoir Dave Minasyan, principal chef de produit chez Microsoft, au cours d'une session sur Ignite. « La découverte de contenu restreint est le moyen d'y parvenir ... vous pouvez verrouiller ou masquer des sites de manière chirurgicale en raisonnant à partir de Copilot. »

Les étapes pour empêcher Copilot d'accéder aux données du site. crédit : Microsoft

Les autorisations d'accès trop généreuses dans le viseur

D'autre outils sont également disponibles dans Purview - la suite logicielle de Microsoft pour la sécurité et la gouvernance des données, disponible dans les abonnements E5 - pour identifier les fichiers surpartagés auxquels Copilot peut accéder. Cela inclut les évaluations de surpartage pour M365 Copilot dans Data Security Posture Management (DPSM) for AI, qui a été lancé en beta publique également lors d'Ignite. Accessibles sur le portail Purview, les évaluations de surpartage mettent en évidence les données susceptibles de présenter un risque en analysant les fichiers à la recherche de données sensibles et en identifiant les référentiels tels que les sites SharePoint dont les approbations d'accès sont appliquées de manière trop large. Des recommandations sont également formulées pour limiter les risques de partage excessif, par exemple en ajoutant des marqueurs de sensibilité ou en limitant l'accès à partir de SharePoint.

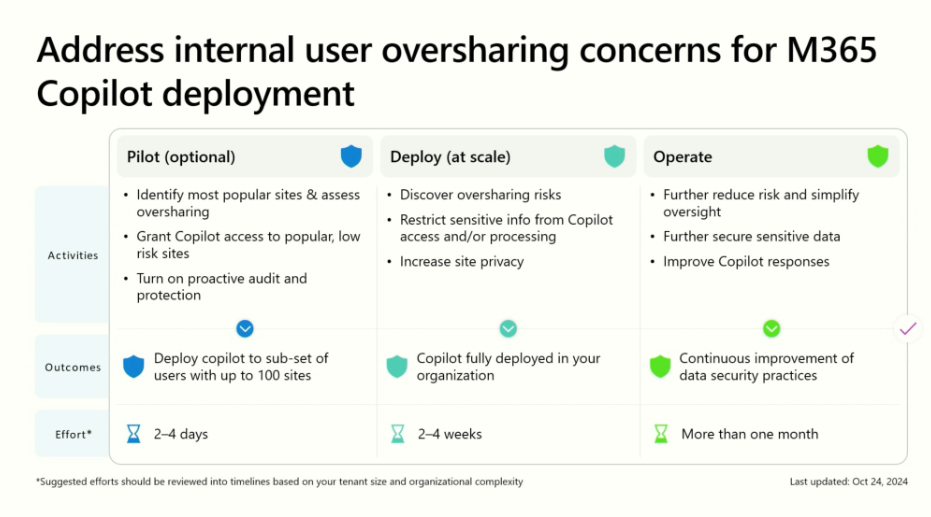

Microsoft Purview Data Loss Prevention for M365 Copilot, également en beta publique, donne aux administrateurs de la sécurité des données la capacité de de créer des politiques de prévention des pertes de données (DLP) afin d'exclure certains documents du traitement par Copilot sur la base du marqueur de sensibilité d'un fichier. Cela s'applique aux fichiers conservés dans SharePoint et OneDrive, mais peut être configuré à d'autres niveaux, tels que le groupe, le site et l'utilisateur, pour apporter plus de flexibilité quant aux personnes autorisées à accéder à certains documents. Un autre outil de Purview, Insider Risk Management, peut désormais être utilisé pour détecter les « utilisations risquées de l'IA ». Il s'agit notamment des prompts contenant des informations sensibles et des tentatives des utilisateurs d'accéder à des informations sensibles non autorisées. Cette fonction, également en beta publique, couvre M365 Copilot, Copilot Studio et ChatGPT Enterprise. Enfin, le site Microsoft Learn propose un modèle décrivant les voies recommandées pour limiter le surpartage au cours des trois étapes du déploiement de M365 Copilot : le pilote, le déploiement et les opérations courantes. Il existe deux modèles : un « chemin fondamental » plus basique et un « chemin optimisé » qui utilise certains des outils de sécurité et de gouvernance des données les plus avancés de l'E5.

Vue d'ensemble de Microsoft pour le déploiement de M365 Copilot. crédit : Microsoft

Des investissements nécessaires pour mieux contrôler M365 Copilot

« Les nouveaux contrôles de gouvernance intégrés de M365 Copilot sont attendus depuis longtemps », a déclaré Jason Wong, vice-président et analyste distingué du Gartner. « Les contrôles de sécurité immatures et les préoccupations liées au partage excessif ont été les principaux défis pour les entreprises qui évaluent et mettent en oeuvre M365 Copilot en 2024. » Une enquête Gartner menée en juin auprès de 132 responsables informatiques a montré que le « surpartage » des données a incité 40 % des répondants à retarder les déploiements de M365 Copilot de trois mois ou plus, tandis que 64% ont affirmé que les risques liés à la gouvernance de l'information et à la sécurité nécessitaient beaucoup de temps et de ressources pour être traités lors des déploiements. L'enquête du cabinet américain indique que les entreprises sont désireuses d'accéder à des outils pour les aider à gérer leurs données : plus d'un quart des personnes interrogées ont mis à niveau leurs licences M365 pour inclure certains services Purview.

Le problème ne concerne pas seulement Microsoft ; une série d'éditeurs de logiciels tiers - Syskit et Varonis, par exemple - promettent également d'aider les entreprises à gérer et à sécuriser leurs données lors du déploiement de M365 Copilot. Selon M. Wong, les clients qui souhaitent déployer M365 Copilot doivent investir dans une série de mesures pour s'assurer que l'assistant GenAI est déployé en toute sécurité, ce qui joue sur la valeur générée par M365 Copilot. « Même avec les fonctionnalités intégrées, la prise en compte du coût total de possession de Copilot et des chiffres du ROI doit inclure toutes les dépenses supplémentaires et l'engagement des ressources nécessaires pour la remédiation de la sécurité et les opérations en cours, y compris la formation des employés sur le stockage et le partage d'informations en toute sécurité », a déclaré M. Wong.

Suivez-nous