Les accélérateurs AMD Instinct MI300X arrivent sur les serveurs Dell

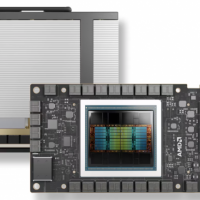

L'accélérateur Instinct MI300X d'AMD arrive sur les serveurs PowerEdge XE9680 de Dell pour accompagner les projets IA. (Crédit AMD)

L'accélérateur Instinct MI300X d'AMD arrive sur les serveurs PowerEdge XE9680 de Dell pour accompagner les projets IA. (Crédit AMD) En option, le PowerEdge XE9680 peut désormais accueillir les GPU Instinct MI300X, les accélérateurs haut de gamme d'AMD conçus pour concurrencer les Nvidia Hopper.

Pour diversifier ses offres et faire jouer la concurrence, Dell propose désormais des serveurs PowerEdge équipés du dernier accélérateur Instinct d'AMD et propose des services de support de déploiement et des logiciels pour créer rapidement des applications d'IA génératives. Le PowerEdge XE9680 est disponible avec les accélérateurs AMD Instinct MI300X (2,61 pétaflops en FP8 en crête), le haut de gamme d'AMD qui rivalise avec la génération de GPU Hopper de Nvidia. Taillé pour les entreprises qui exploitent l'IA générative, ce peut accueillir jusqu'à huit accélérateurs MI300X, avec une mémoire HBM3 combinée de 1,5 To, donnant au final une capacité de calcul théorique en pointe de 42 pétaflops en FP8. Cette configuration est conçue pour une formation et une inférence plus rapides des modèles de langage volumineux (LLM). Dans le cadre des tests, le texan a déployé un modèle Llama 2 de 70 milliards de paramètres sur un serveur doté d'un seul accélérateur MI300X. Il a également peaufiné ce même modèle avec la précision FP16 sur un serveur Dell PowerEdge XE9680 équipé de huit accélérateurs AMD Instinct MI300X. Le PowerEdge XE9680 est livré avec le logiciel de gestion de serveur centralisé OpenManage Enterprise, pour un déploiement rapide et simple, le logiciel d'automatisation APEX AIOps et des fonctionnalités intégrées de cyberrécupération et de sécurité zero trust .

Des conceptions validées pour rationaliser les déploiements GenAILe texan propose également sa conception validée pour l'IA générative avec AMD, un cadre standard destiné aux entreprises qui gèrent leurs propres LLM. Annoncées en mai et disponibles aujourd'hui, les conceptions validées visent à faciliter le déploiement par les entreprises de systèmes d'inférence LLM et de personnalisation de modèles. « Ce guide de conception fournit aux entreprises et aux développeurs des instructions complètes pour mettre en oeuvre l'inférence LLM et la personnalisation des modèles, ainsi que des techniques avancées telles que le réglage fin et le RAG (génération augmentée de récupération). S'appuyant sur des normes ouvertes et réduisant le besoin de suites logicielles d'IA propriétaires, les développeurs peuvent simplifier le développement et personnaliser librement les flux de travail avec des modèles LLM open source de partenaires tels que Hugging Face et Meta », a écrit Luke Mahon, directeur de l'équipe d'ingénierie marketing technique des solutions Dell AI, dans un article de blog sur ces produits et services.

Côté logiciel, le fournisseur livre des frameworks basés sur AMD ROCm pour prendre en charge les LLM open source tels que PyTorch, TensorFlow, ONNX-RT et JAX, ainsi que la pile complète de pilotes, de kits d'outils de développement et d'API pour les accélérateurs AMD Instinct. De plus, « Dell Omnia simplifie la création et la gestion des clusters d'IA en automatisant la configuration pour un traitement efficace des charges de travail », a écrit M. Mahon. Pour rappel Omnia est une boîte à outils open source pour le déploiement et la gestion de clusters hautes performances pour les workloads HPC, IA et d'analyse de données. Pour aider ses clients dans leurs initiatives d'IA, Dell a dévoilé en septembre des services de mise en oeuvre de plateforme. Les consultants aideront les clients à établir une plateforme pour la création et le déploiement d'outils et de cadres d'IA. Le fournisseur proposera également des ateliers d'accélération d'une demi-journée pour aider les entreprises à déterminer comment elles peuvent tirer le meilleur parti de l'IA.

Edition du 22/07/2024, par Andy Patrizio, IDG NS (adapté par Serge Leblal)

Sur le même sujet